SMART отчет №2

Первый был летом 2018

SSD Total Bytes Written

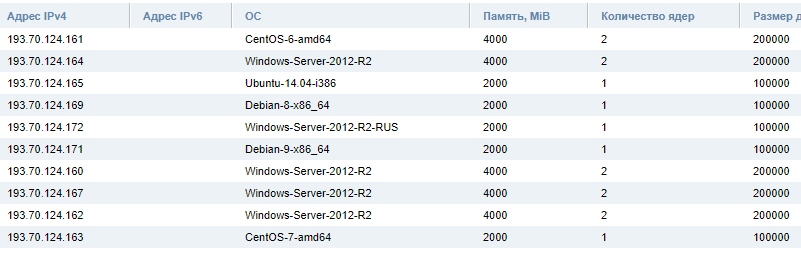

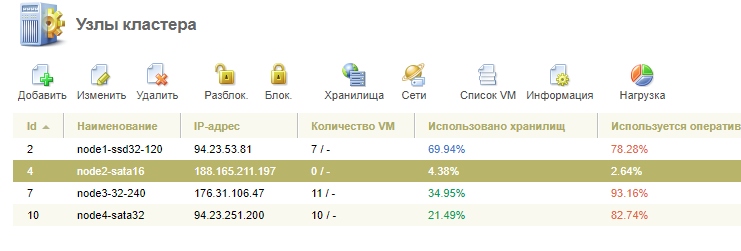

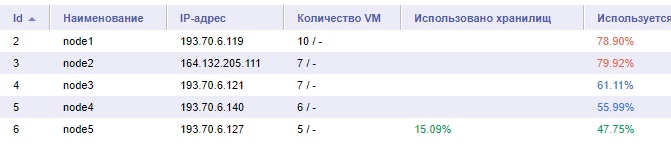

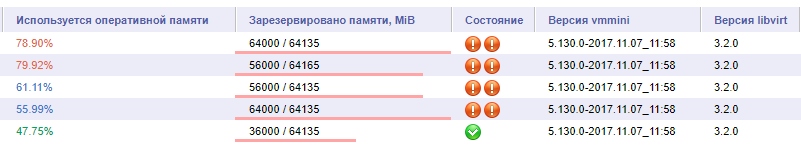

Точно так же смотрим только ноды, где 1 SSD без raid1

Потому что там сгорание равносильно смерти узла.

SBG i7-6700k

noda1 — 272379466896 — 126.84 TB — 0 ошибок

noda2 — 295425295251 — 137.57 TB — 0 ошибок

noda3 — 766966834999 — 357.15 TB — 0 ошибок

noda4 — 185514307689 — 86.39 TB — 0 ошибок

noda5 — 181434747397 — 84.49 TB — 0 ошибок

noda6 — 558204424554 — 259.93 TB — 0 ошибок

noda01 2016 — 378695466309 — 176.34 TB — 0 ошибок

noda02 2016 — 165944088769 — 77.27 TB — 0 ошибок

GRA i7-6700k

noda1 — 172324367138 — 80.24 TB — 0 ошибок

noda2 — 53503605961 — 24.91 TB — 0 ошибок

noda3 — 50002184870 — 23.28 TB (меняли ноду) — 0 ошибок

noda4 — 233938 — 0 ТБ (либо ошибка, либо так и осталось с прошлого замера) — 0 ошибок

noda5 — 106640635623 — 49.66 TB (меняли ноду) — 0 ошибок

noda6 — 86617391991 — 40.33 TB — 0 ошибок

noda7 — 38769693909 — 18.05 TB — 0 ошибок

noda8 — 13825987528 — 6.44 TB — 0 ошибок

noda01 2016 — 266791112841 — 124.23 TB — 0 ошибок

noda02 2016 — 250296977064 — 116.55 TB — 0 ошибок

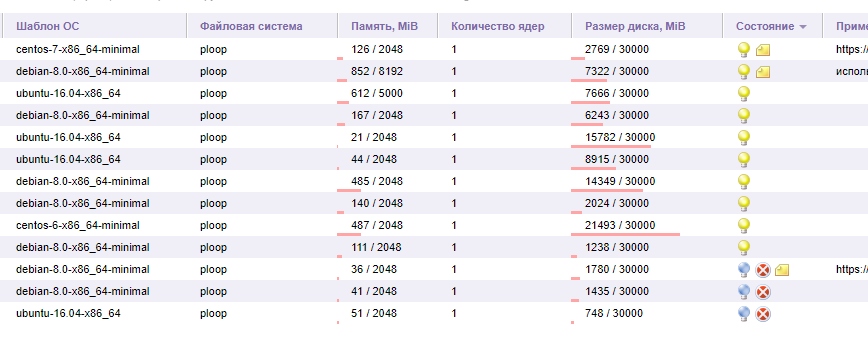

Так же было решено сохранить для будущего понимания.

Полноценные смарты.

И в конце 2019 года сохранить еще раз.

И сравнить какие показатели увеличились, какие наоборот уменьшились.

Чтобы понять что происходит со временем.

Судя по всему, возможно мы так и не увидим собственными глазами как сгорят эти ноды :)

Быстрее процессоры потеряют актуальность.