MSK.lowcost-7950x [noda8] [russia.network]

- Историю и пример, как анонисировать ноды можно почитать

- Правила портала VM.center

- Добавлено на узел selectel.vmmanager.app/auth/

- Добавлена в честную Историю — list.skladchik.ovh (2024 год узлы смотреть)

- А так же добавлено в мониторинг.

- Конкретно эта нода stats.uptimerobot.com/Mgd9czIBWb/802509080

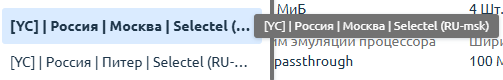

Итак, добавлена noda6 [Selectel-MSK-2]

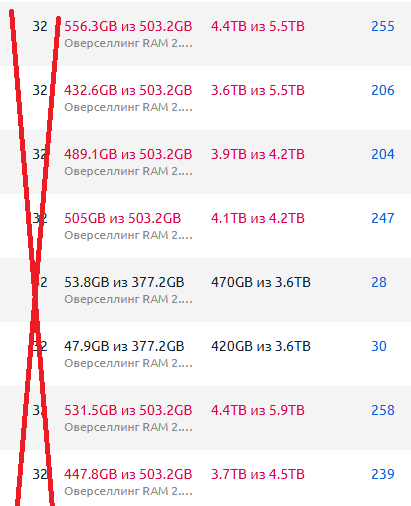

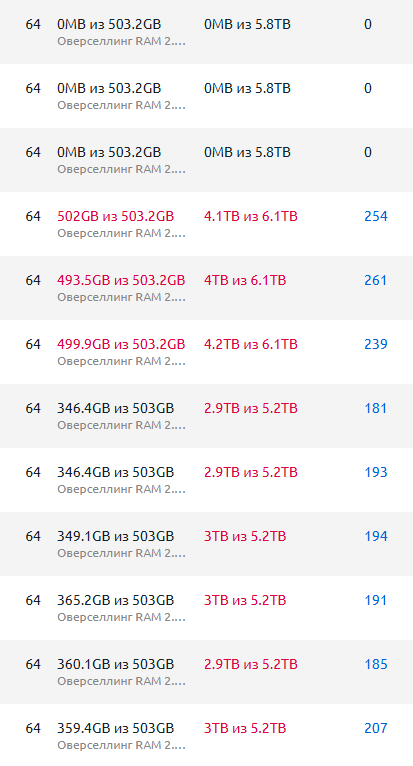

IP — 16-32 штук.

Доля/Тариф на 1 долю (можно соединять)

- 7950x (4,5 ГГц) [1 vCore] / 1 DDR4 / 25 ГБ SSD

- Старт 03-2026 год — цена 350р

- С 03-2027 цена — далее 350р (так как больше нету понятия «вечная лицензия и с второго года уже не дешевле»)

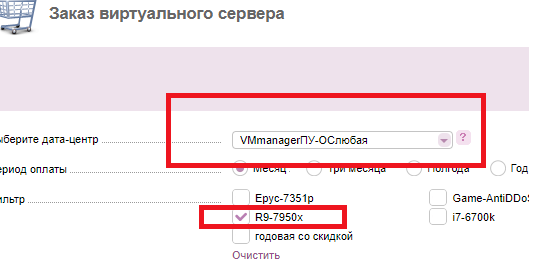

Автоматически можно заказать

Биллинг панели где доступно

bill.yacolo.net/billmgr — Selectel выбирать МСК или Питер

На этом проекте поддержки нет. Но у других хостеров на портале vm.center — будет, но и цены там будут другие и анонсы тоже ;)