vm.spacecore.pro - I7-8700 [noda2-HEL]

Представляем вашему вниманию нашу новую ноду I7-8700 [noda2-HEL] в одном из лучших дата центров в Финляндии с AntiDDos защитой и каналом в 1 GBit/s. Нужно больше скорости? Новые NVME накопители в 3 раза быстрее даже самых высокоскоростных SSD и все это по самой низкой цене на рынке!

Конфигурация:

Intel i7-8700 6c/12t 4.6GHz

64GB DDR4

2x1024GB NVME SSD

1 GBit/s

Локация: Финляндия

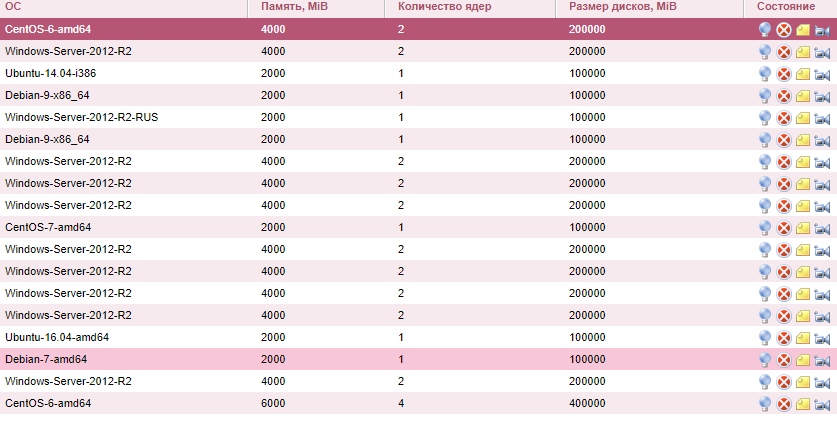

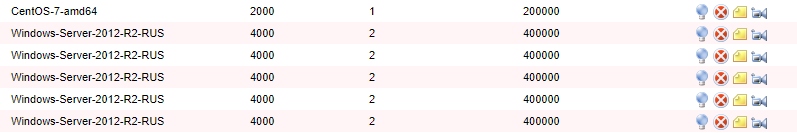

Тариф на 1 долю

(можно добавлять)

1 vCore i7-8700

4 GB DDR4-памяти

100 GB NMVe SSD

1 GBit/s

Standard-AntiDDos

Старт 03-2020 год — цена 550р

Контакты для связи:

Email: support@spacecore.pro

Telegram: @spacecore_pro

VK: vk.com/spacecore_pro

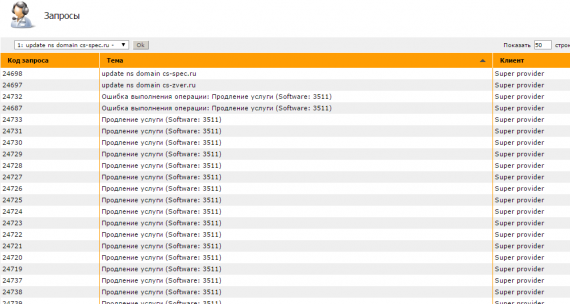

Биллинг: billing.spacecore.pro