Первая авария на VMmanager 6 версии (всем пострадавшим 1 месяц начислено бесплатно)

Хоть они и заявляют о стабильности, но на 2021 год — пока что это не так.

За 2020 было проделано много работы, что-то стало лучше, что-то стало хуже.

Например хуже стало то, что при создании кластера нельзя теперь указать настройки для него, например выставить лимит на канал, в итоге все ВМ создаются без ограничений и потом приходится вручную уже всем настраивать после создания ВМ. А раньше эта функция бралась из создания кластера, просто когда его создашь там указывалось.

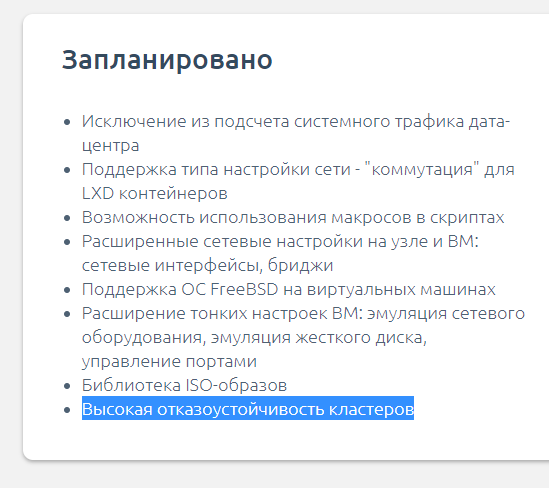

А лучше стало наверно то, что больше функционала, все таки Март 2020, Апрель 2020 и Ноябрь 2020 — это небо и земля.

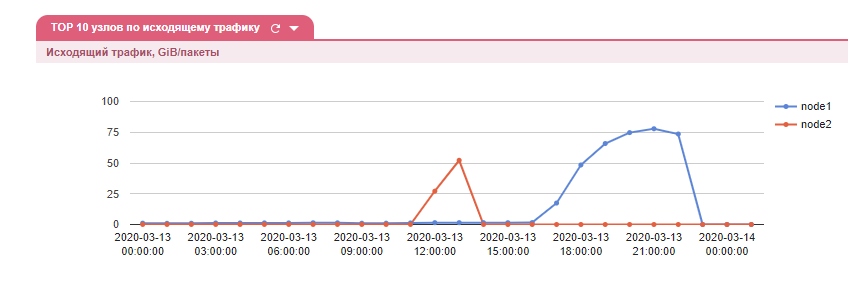

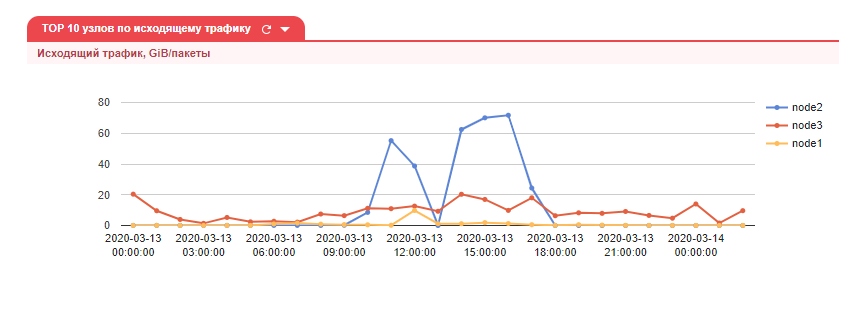

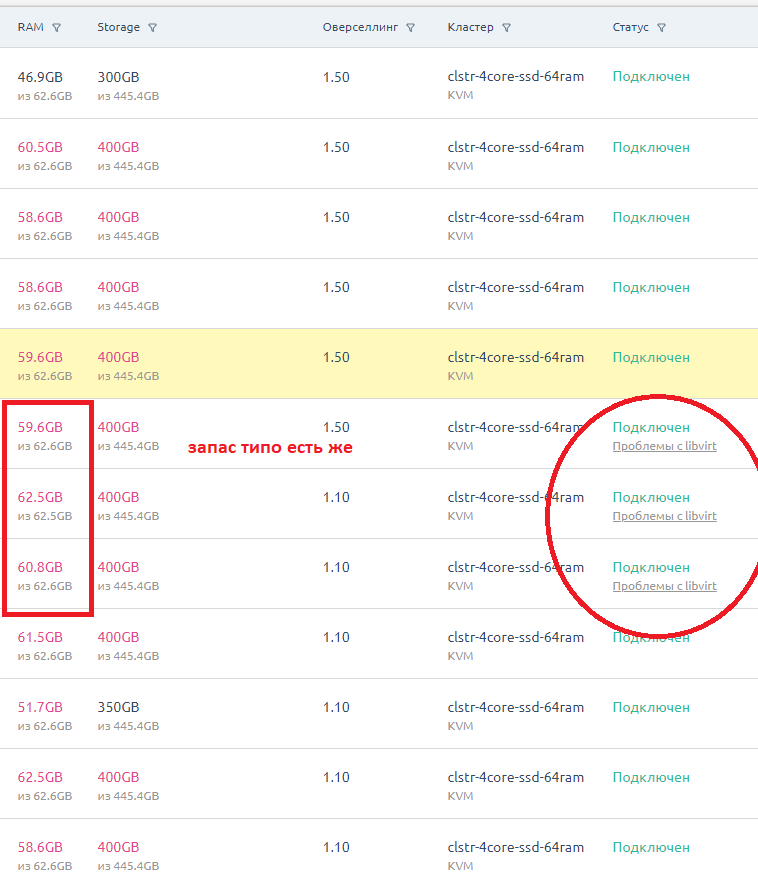

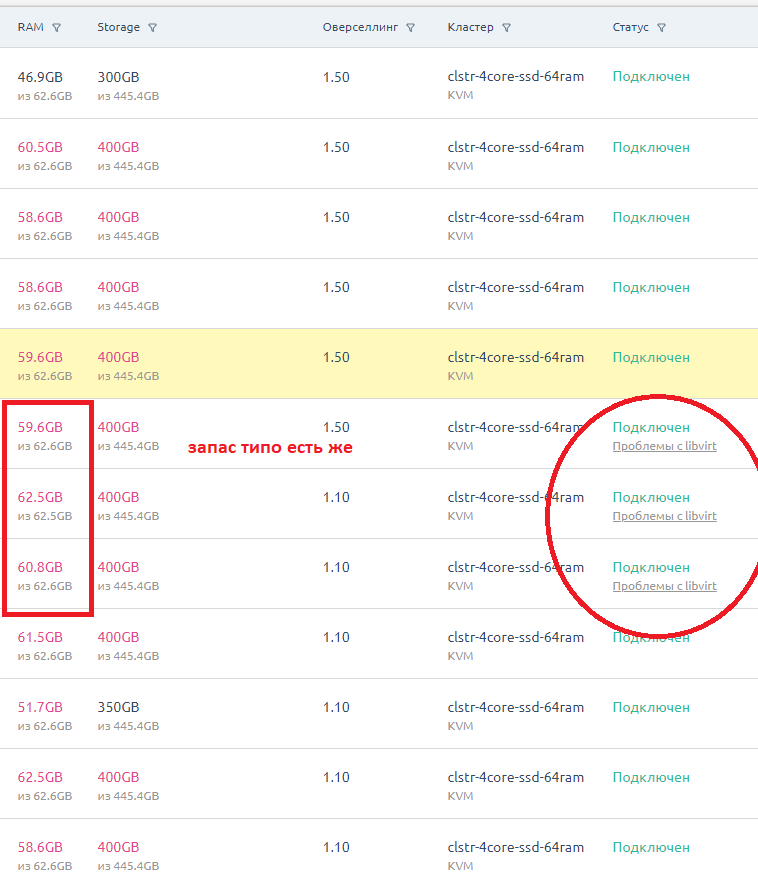

Короче по каким-то причинам часть узлов стала писаться якобы проблемы на узле.

Но узлы работали и ВМ на них работали.

Хотя в панели показывался статус что ВМ отключена и не работает.

Ради теста я перезагрузил 1 узел, он перестал писаться с ошибками. Но зато ВМ-ки на нем перестали работать.

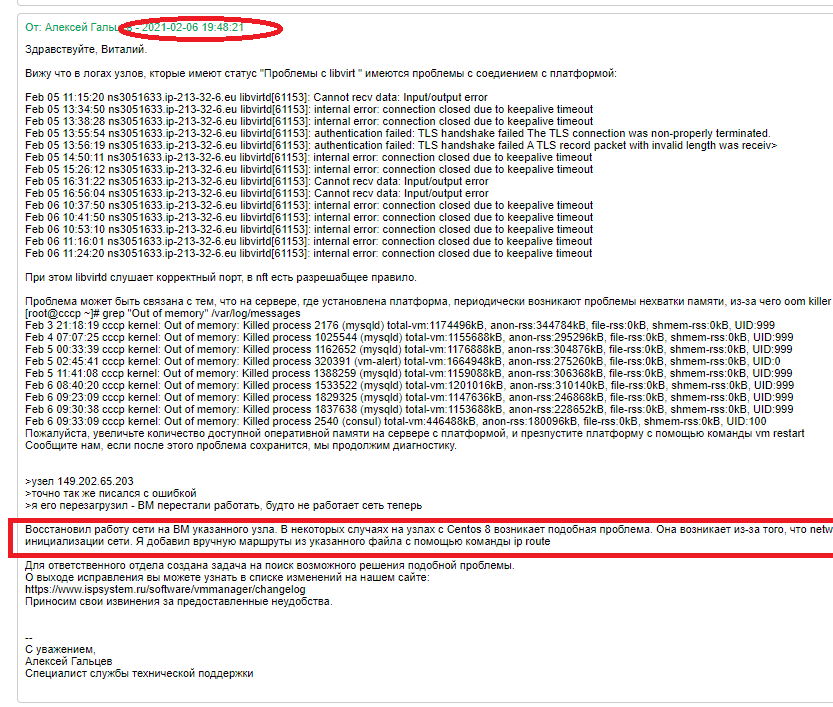

В итоге почти сутки ISPsystem пытались разобраться в проблеме.

И до сих пор пока что проблема не исправлена.

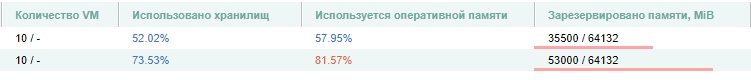

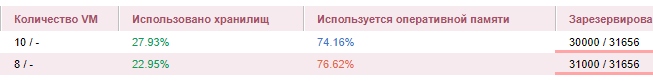

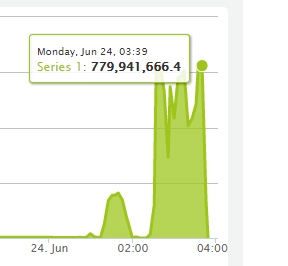

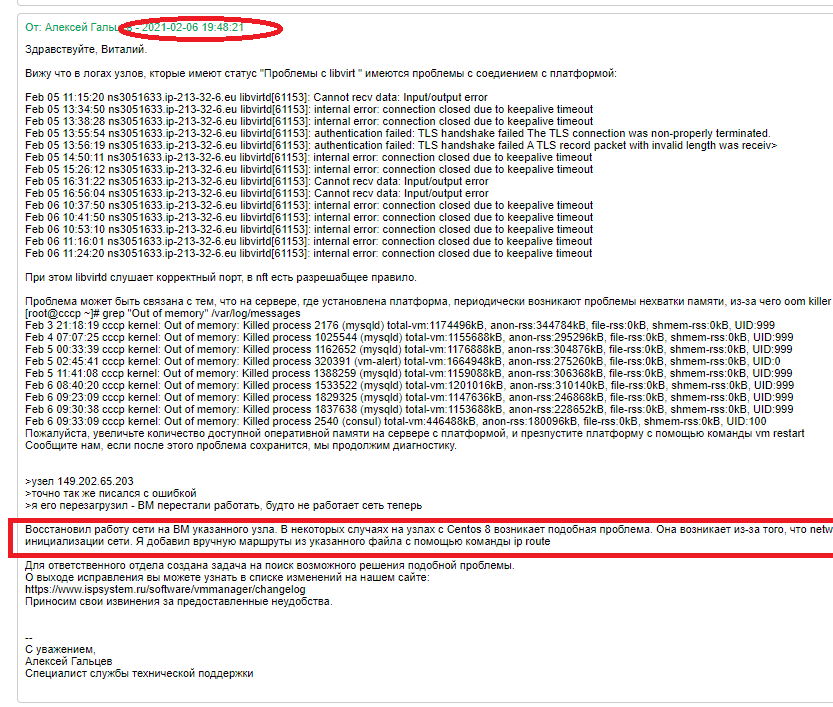

Пишут что утечка ОЗУ, хотя сама панель их показывает что 2 ГБ в запасе.

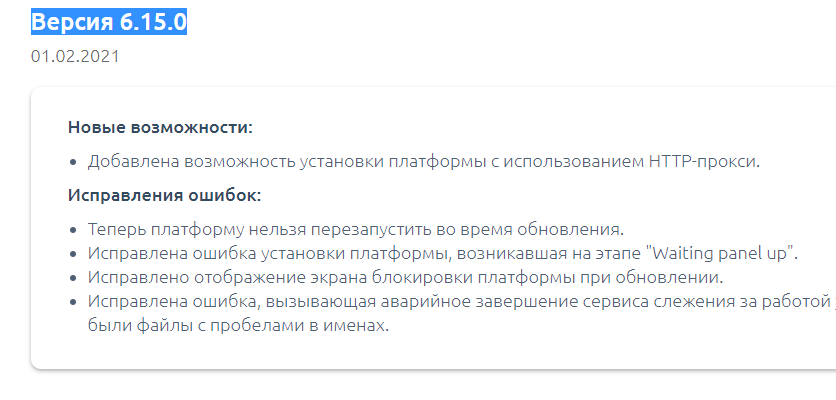

Вероятно эта проблема случилась после обновления

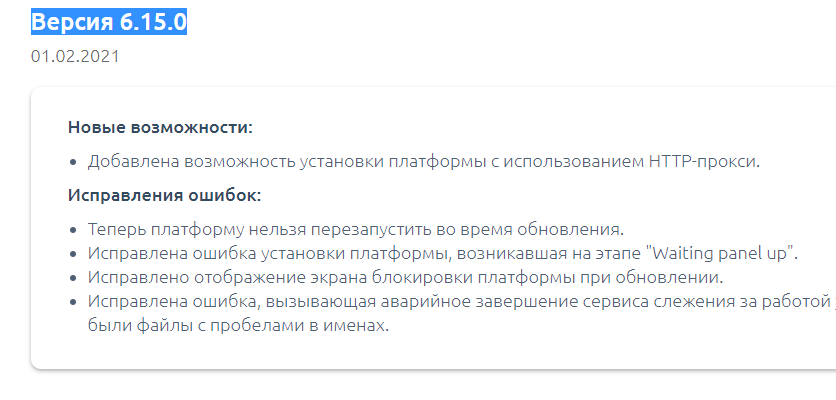

Версия 6.15.0 VMmanager KVM 6

На VMmanager 5 — были похожие проблемы ранее.

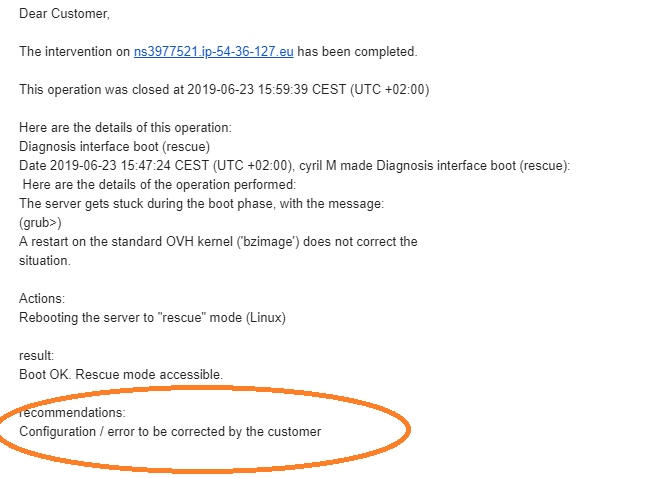

Так вот, короче я перезагрузил 1 узел — и он сдох.

И вот всем кто пострадал на этом узле — 1 месяц бесплатно :)

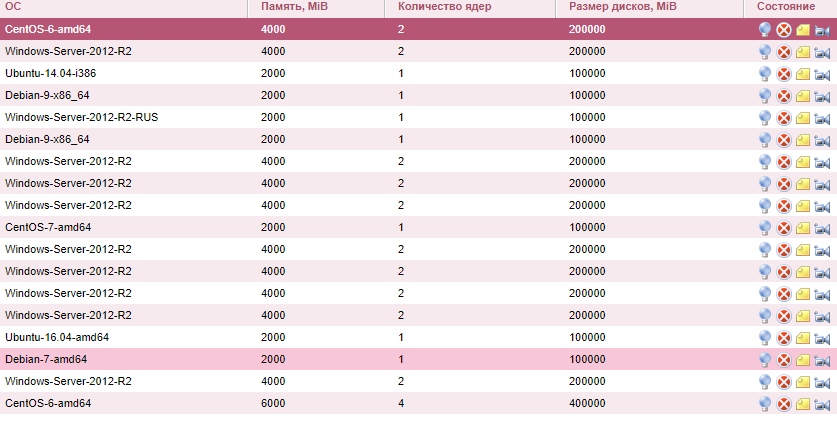

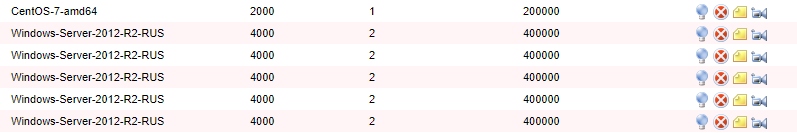

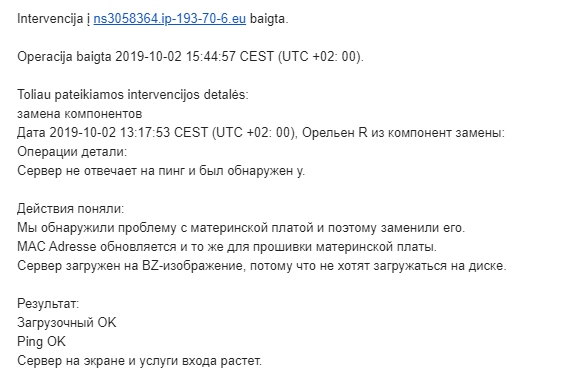

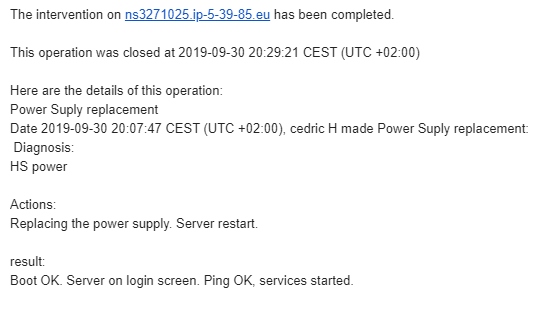

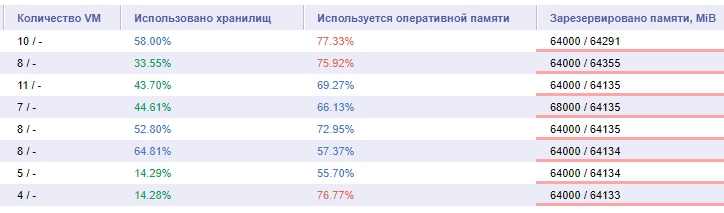

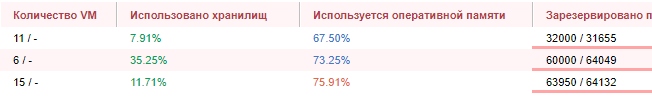

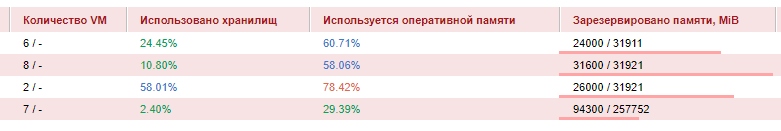

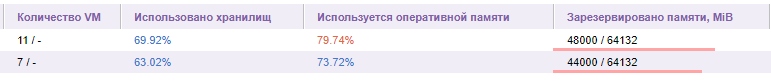

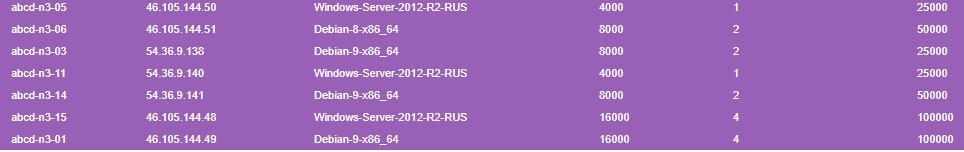

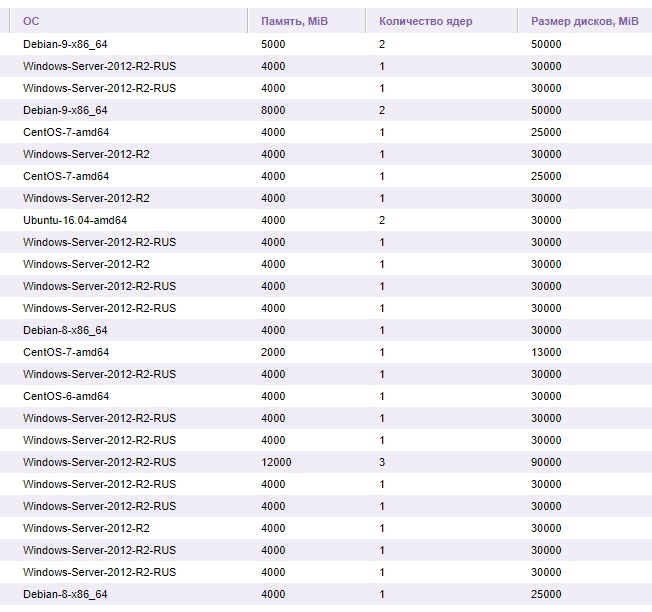

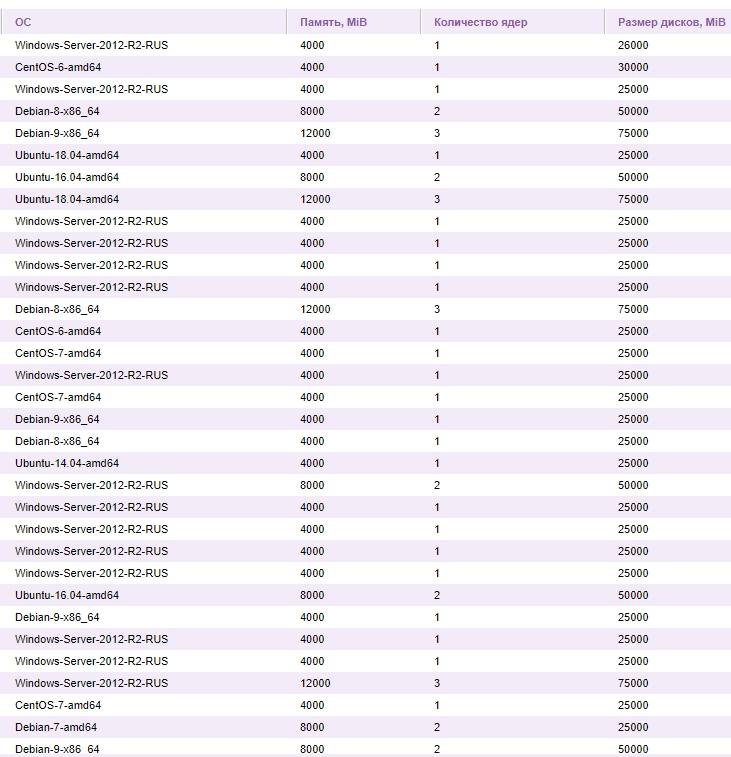

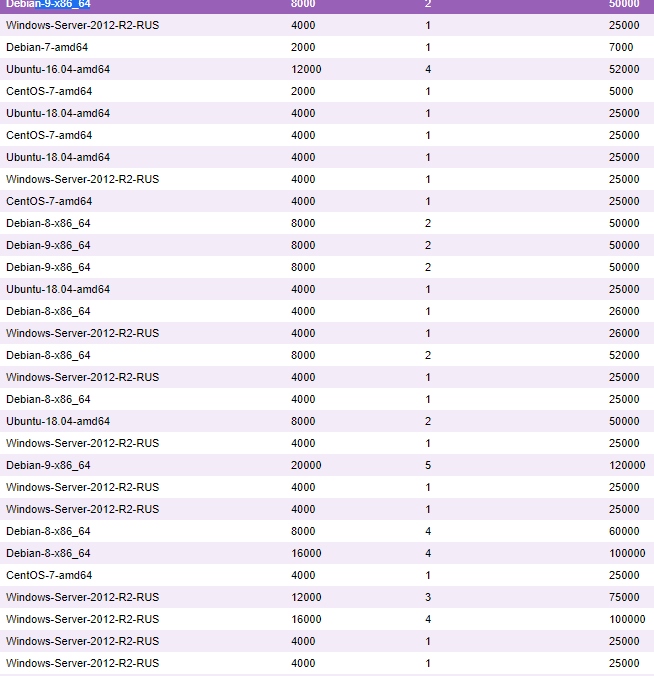

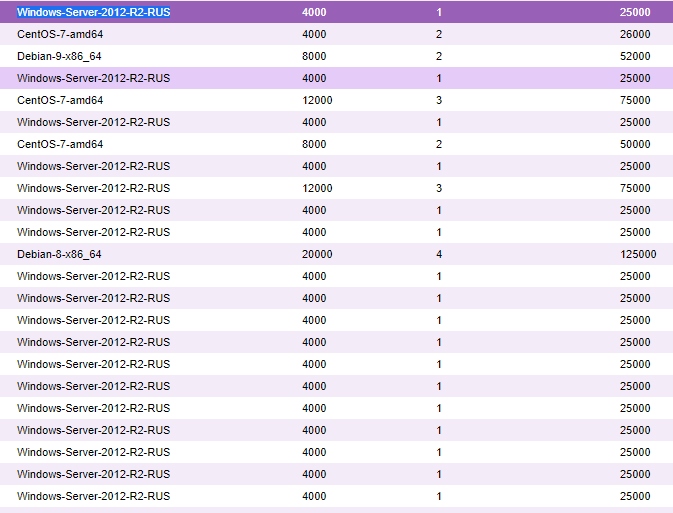

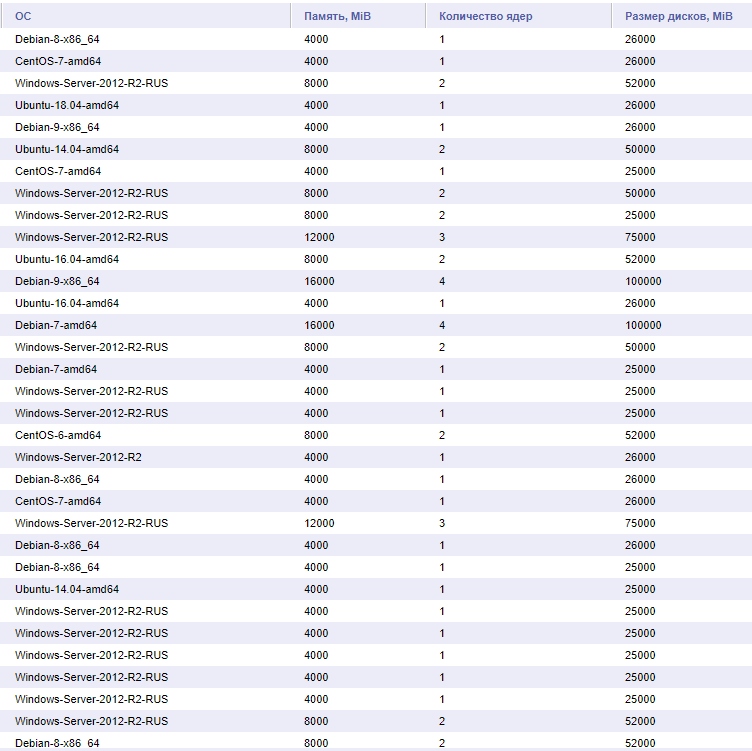

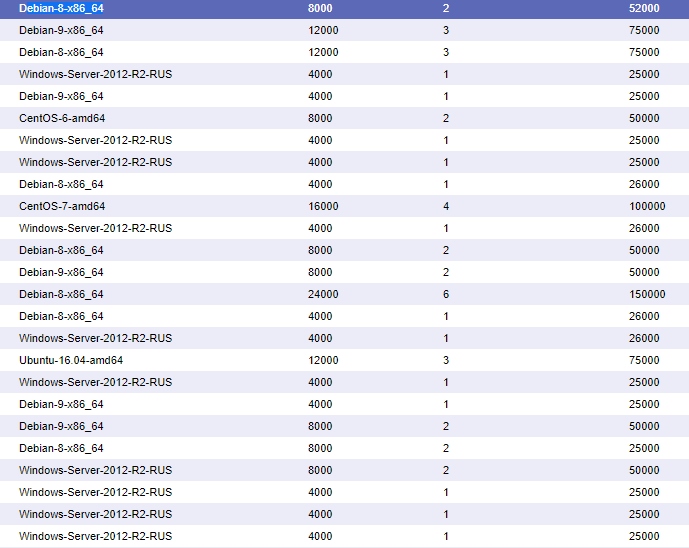

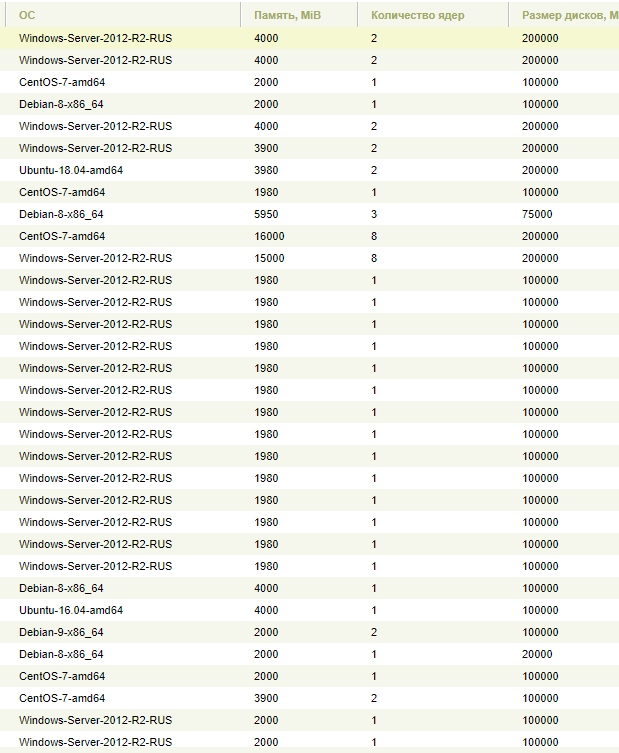

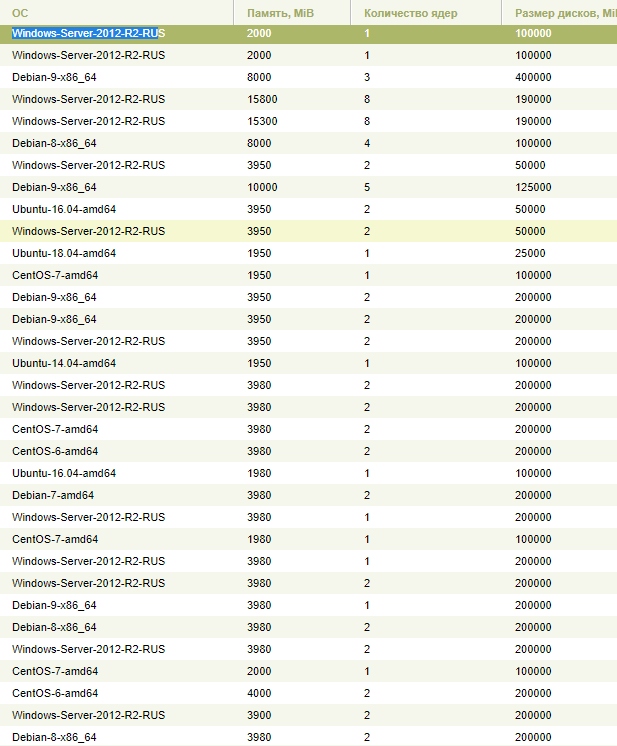

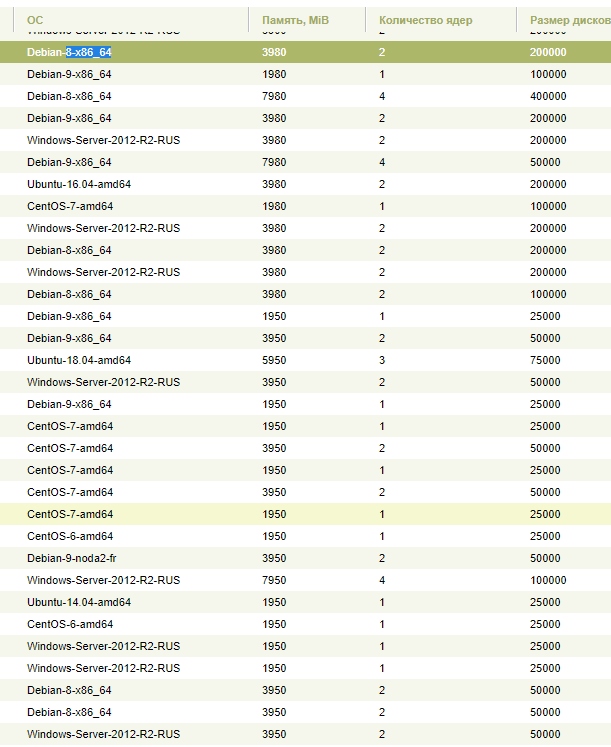

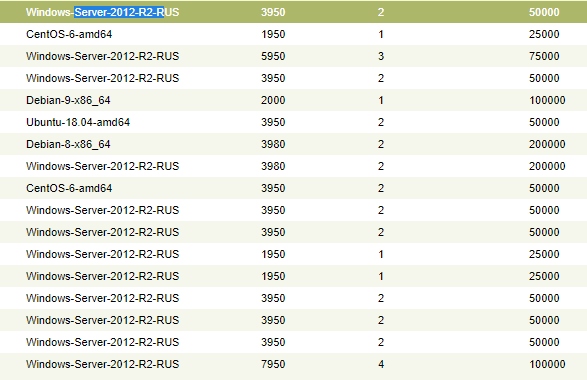

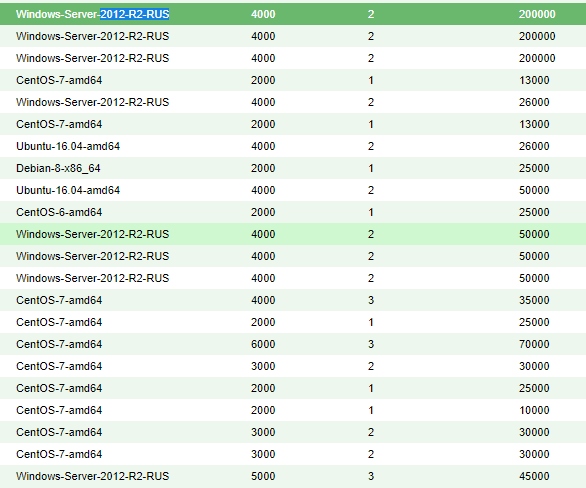

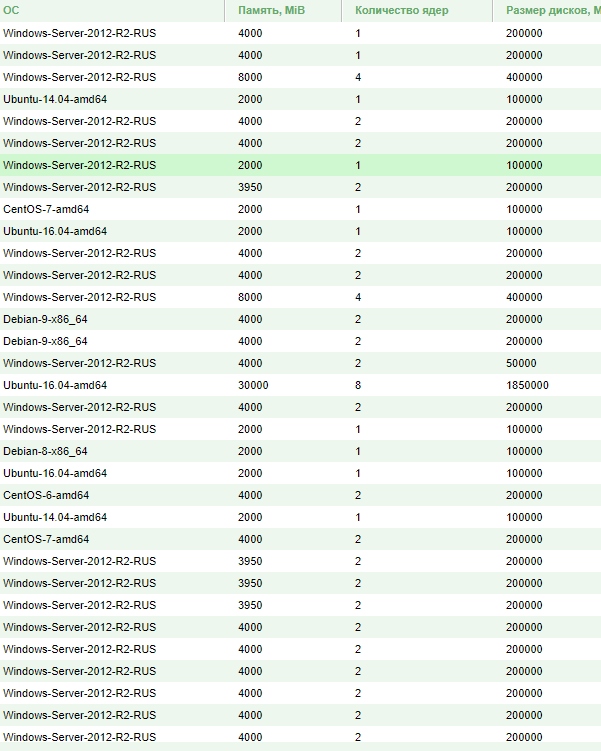

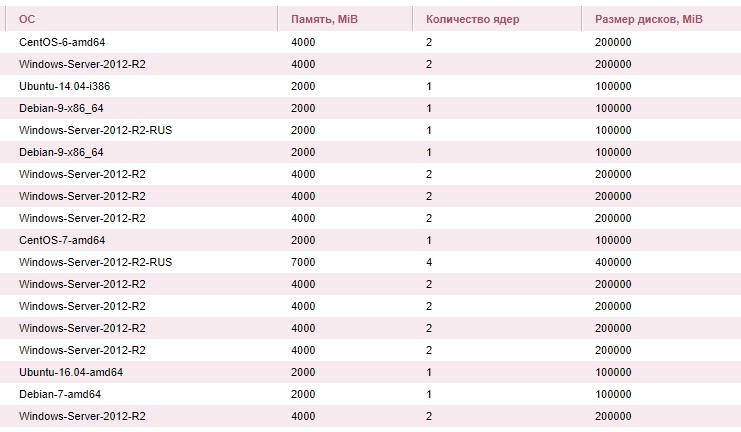

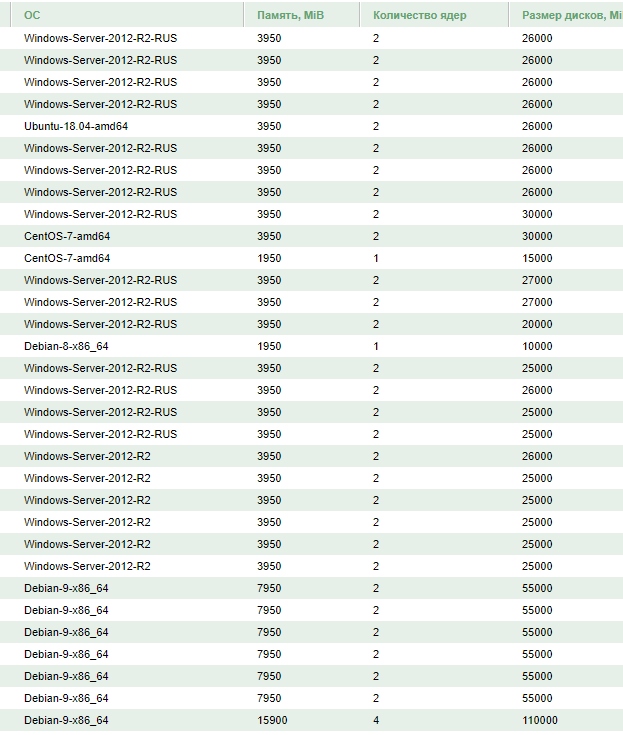

Вот этим чувакам.

И в публичные отчеты честности для истории.

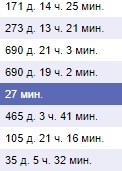

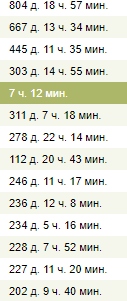

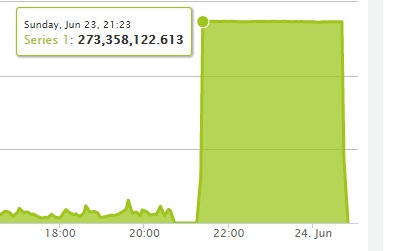

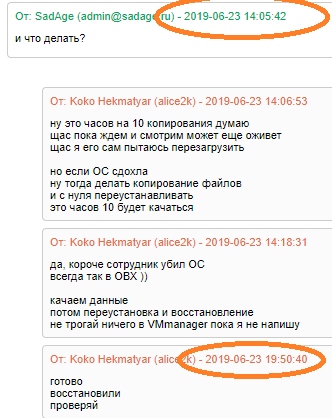

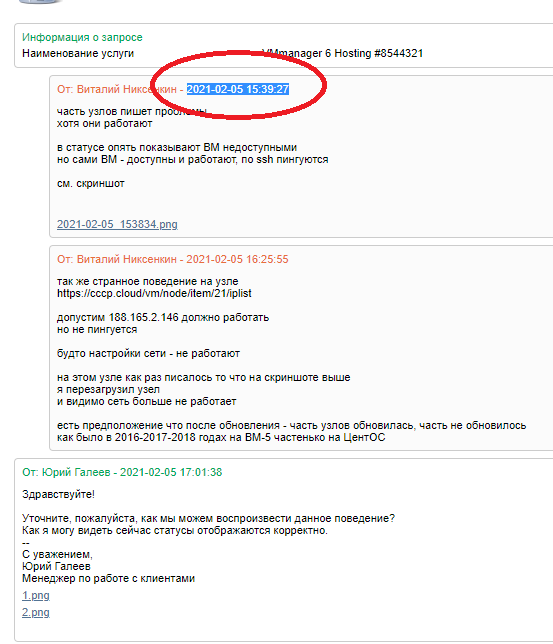

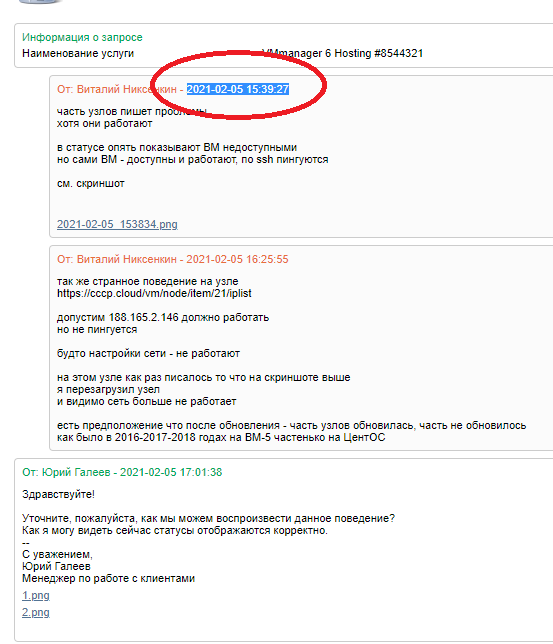

Дата подачи заявки о проблеме панели.

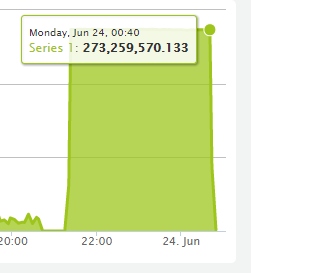

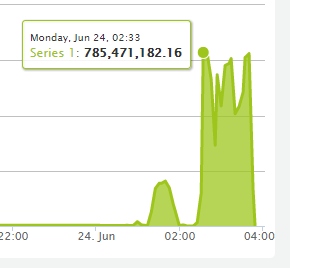

Но восстановлен узел был только.

Почти 24 часа короче.

Такие вот дела. Извиняюсь хоть это и не косяк хостера.

За 2020 было проделано много работы, что-то стало лучше, что-то стало хуже.

Например хуже стало то, что при создании кластера нельзя теперь указать настройки для него, например выставить лимит на канал, в итоге все ВМ создаются без ограничений и потом приходится вручную уже всем настраивать после создания ВМ. А раньше эта функция бралась из создания кластера, просто когда его создашь там указывалось.

А лучше стало наверно то, что больше функционала, все таки Март 2020, Апрель 2020 и Ноябрь 2020 — это небо и земля.

Короче по каким-то причинам часть узлов стала писаться якобы проблемы на узле.

Но узлы работали и ВМ на них работали.

Хотя в панели показывался статус что ВМ отключена и не работает.

Ради теста я перезагрузил 1 узел, он перестал писаться с ошибками. Но зато ВМ-ки на нем перестали работать.

В итоге почти сутки ISPsystem пытались разобраться в проблеме.

И до сих пор пока что проблема не исправлена.

Пишут что утечка ОЗУ, хотя сама панель их показывает что 2 ГБ в запасе.

Вероятно эта проблема случилась после обновления

Версия 6.15.0 VMmanager KVM 6

На VMmanager 5 — были похожие проблемы ранее.

Так вот, короче я перезагрузил 1 узел — и он сдох.

И вот всем кто пострадал на этом узле — 1 месяц бесплатно :)

Вот этим чувакам.

И в публичные отчеты честности для истории.

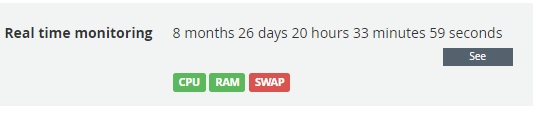

Дата подачи заявки о проблеме панели.

2021-02-05 15:39:27

Но восстановлен узел был только.

2021-02-06 19:48:21

Почти 24 часа короче.

Такие вот дела. Извиняюсь хоть это и не косяк хостера.