[vmmanager6] changelog 2024

История

Версия 2024.12.1

03.12.2024

Изменения:

Количество BGP-сессий для виртуальных сетей кластера ограничено до 32.

На форме подключения ISO-образа убран метод загрузки «Из репозитория», если в репозитории нет ISO-образов.

Новые возможности:

Для версии VMmanager Infrastructure добавлена поддержка ОС Astra Linux Special Edition 1.8.1 для сервера с платформой и узлов кластера. Подробнее об обновлении ОС: ispsystem.ru/docs/x/ZgLJDw

Улучшения:

В списках ВМ и узлов кластера добавлена возможность скопировать IP-адрес по клику.

На вкладке «Переменные для скриптов» добавлены подсказки о том, что управление встроенными переменными недоступно.

Исправления ошибок:

Исправлена ошибка, из-за которой в настройках сетевых интерфейсов при миграции неверно отображались распределённые интерфейсы ВМ.

Исправлена ошибка, возникавшая при редактировании примечания к пулу IP-адресов.

Исправлена ошибка, из-за которой на форме добавления IP-адреса было невозможно выбрать интерфейс при переключении типа сети с виртуальной на основную.

Исправлена проблема, из-за которой для новых ВМ с ОС Windows IP-адреса не выдавались автоматически.

Исправлена ошибка, из-за которой было невозможно подключить хранилище, если ранее к узлу было подключено SAN-хранилище.

Исправлена ошибка, из-за которой на форме создания резервных копий не отображались диски, не подключённые к ВМ.

Читать дальше

- [vmmanager6] changelog 2023

- [vmmanager6] changelog 2022

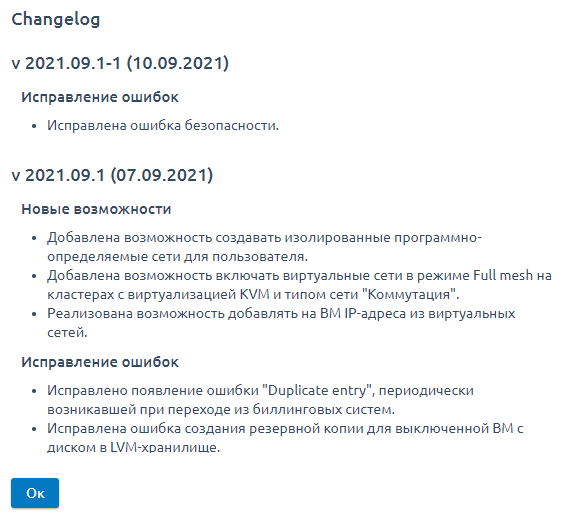

- [vmmanager6] changelog 2021

- [vmmanager6] changelog 2020

- [vmmanager6] changelog 2019

Версия 2024.12.1

03.12.2024

Изменения:

Количество BGP-сессий для виртуальных сетей кластера ограничено до 32.

На форме подключения ISO-образа убран метод загрузки «Из репозитория», если в репозитории нет ISO-образов.

Новые возможности:

Для версии VMmanager Infrastructure добавлена поддержка ОС Astra Linux Special Edition 1.8.1 для сервера с платформой и узлов кластера. Подробнее об обновлении ОС: ispsystem.ru/docs/x/ZgLJDw

Улучшения:

В списках ВМ и узлов кластера добавлена возможность скопировать IP-адрес по клику.

На вкладке «Переменные для скриптов» добавлены подсказки о том, что управление встроенными переменными недоступно.

Исправления ошибок:

Исправлена ошибка, из-за которой в настройках сетевых интерфейсов при миграции неверно отображались распределённые интерфейсы ВМ.

Исправлена ошибка, возникавшая при редактировании примечания к пулу IP-адресов.

Исправлена ошибка, из-за которой на форме добавления IP-адреса было невозможно выбрать интерфейс при переключении типа сети с виртуальной на основную.

Исправлена проблема, из-за которой для новых ВМ с ОС Windows IP-адреса не выдавались автоматически.

Исправлена ошибка, из-за которой было невозможно подключить хранилище, если ранее к узлу было подключено SAN-хранилище.

Исправлена ошибка, из-за которой на форме создания резервных копий не отображались диски, не подключённые к ВМ.