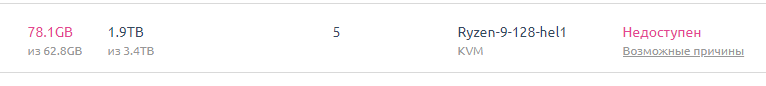

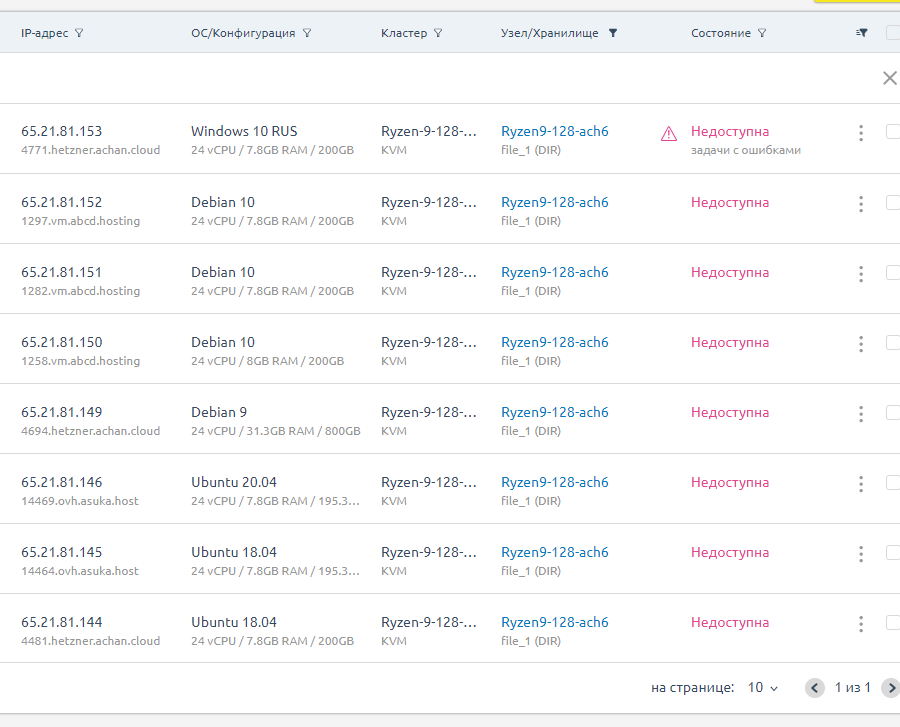

Ryzen брак - закрыли №2

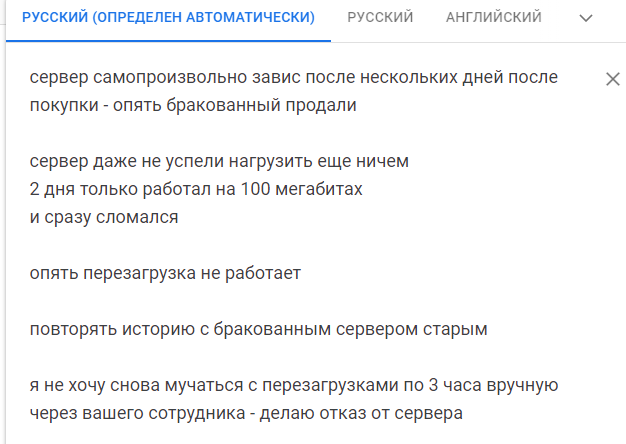

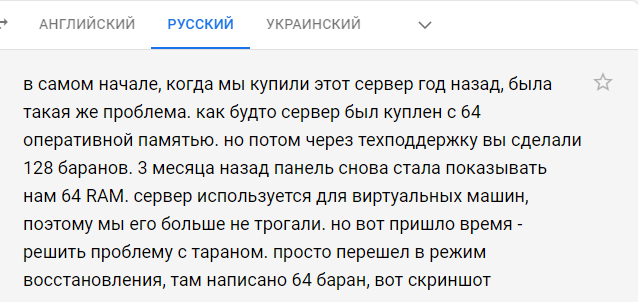

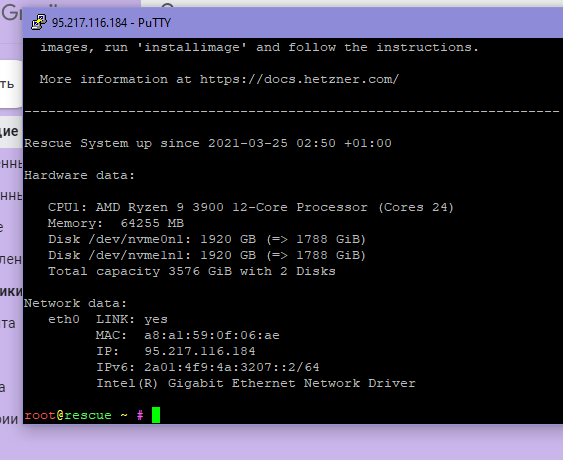

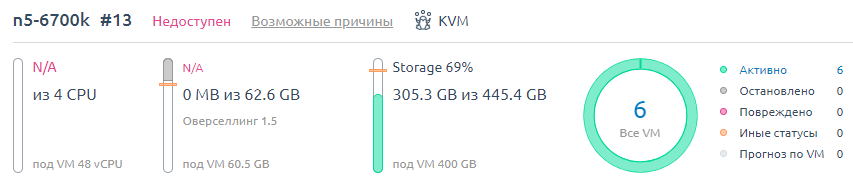

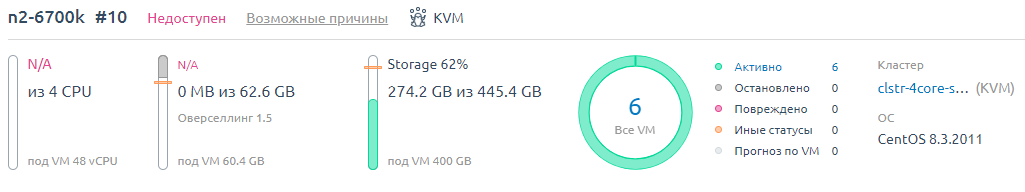

Самопроизвольно завис

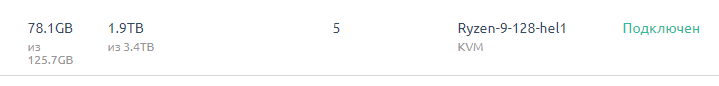

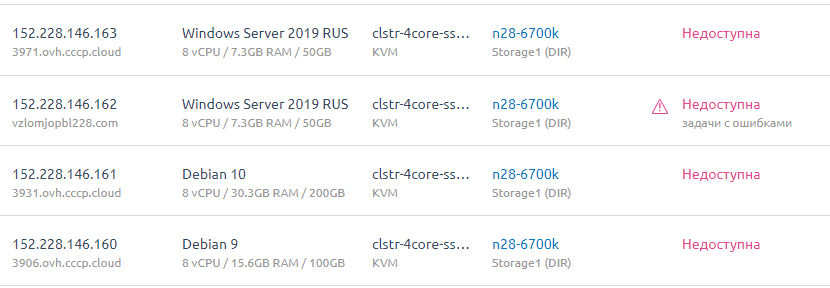

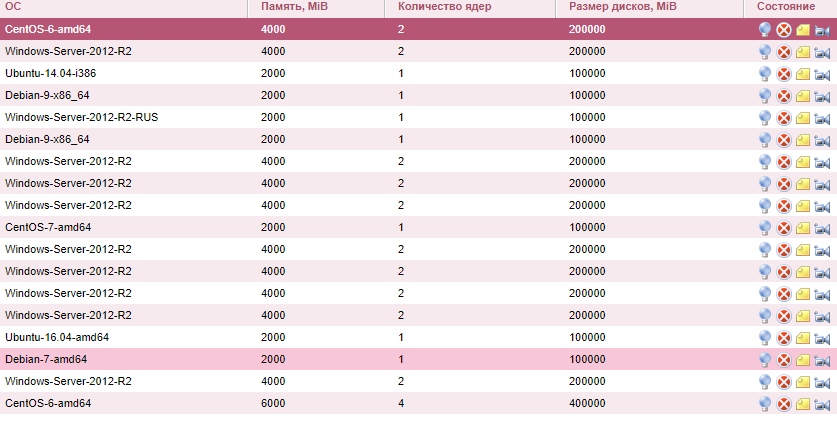

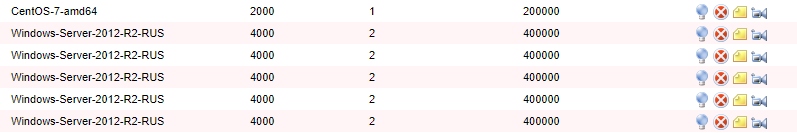

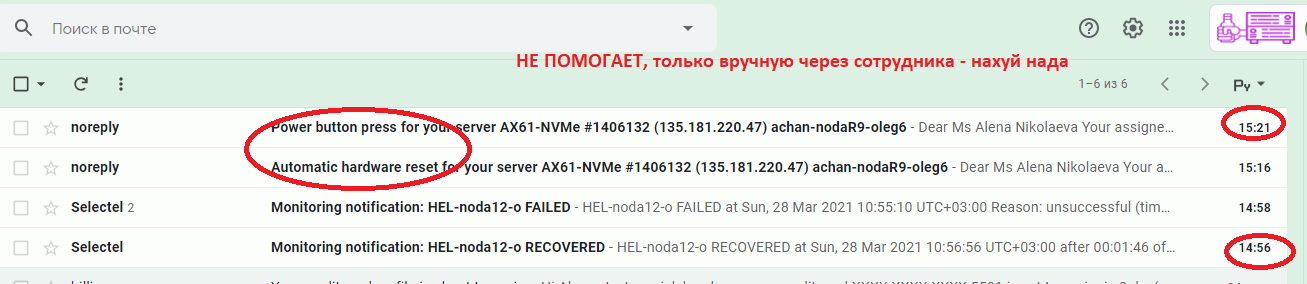

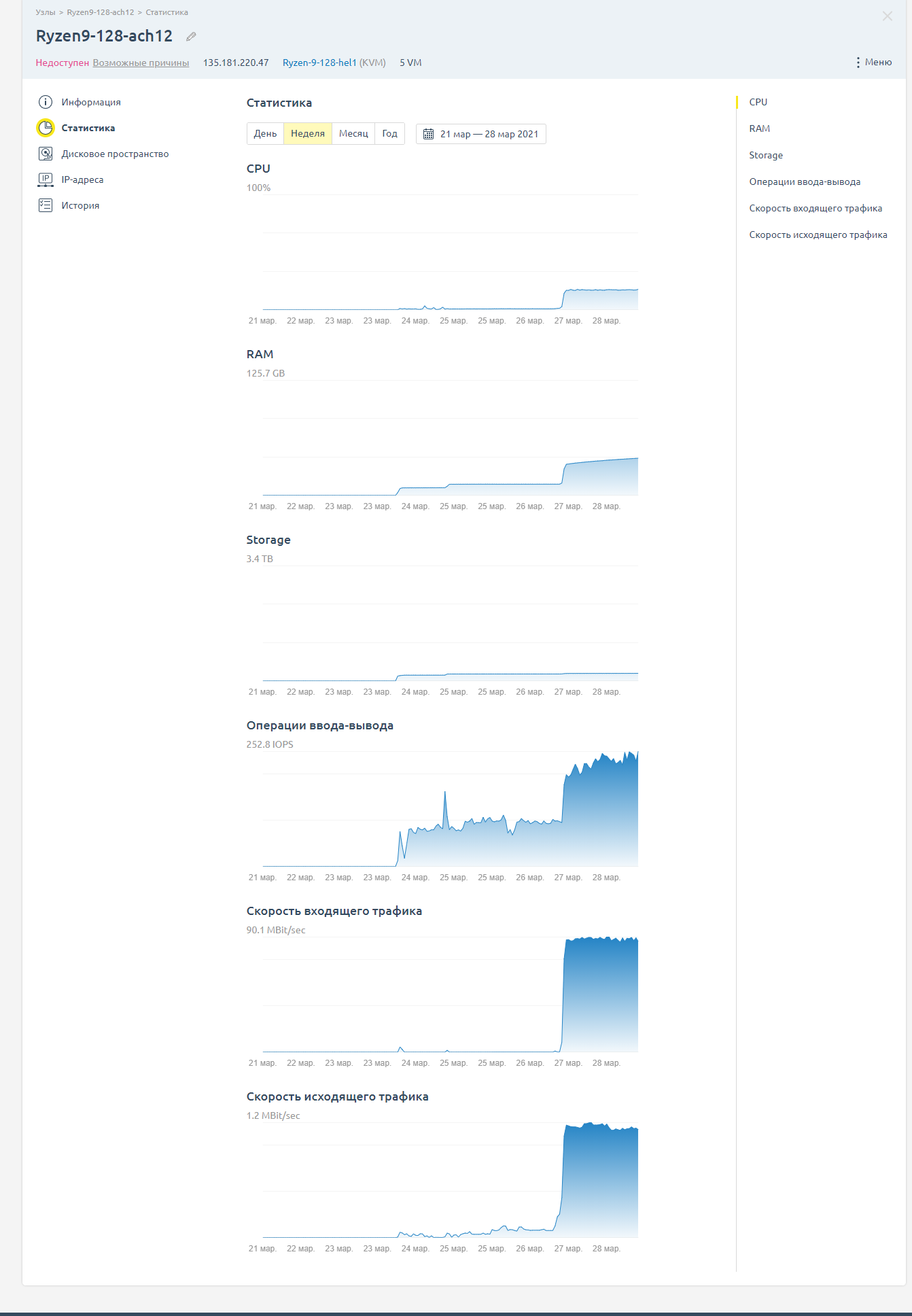

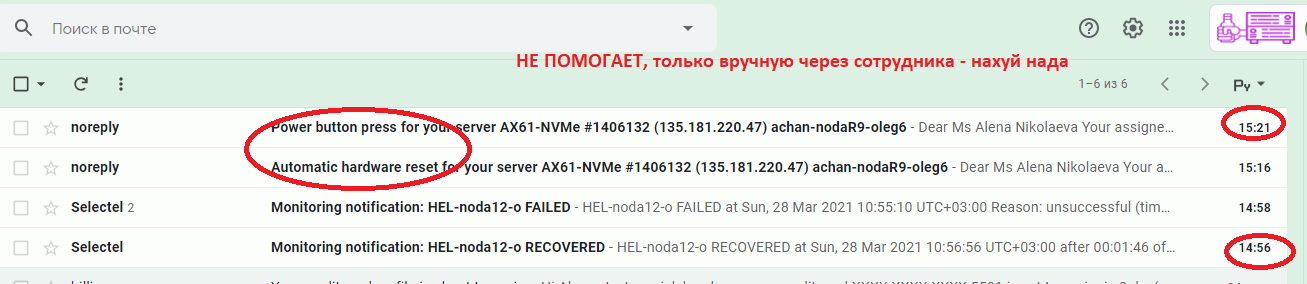

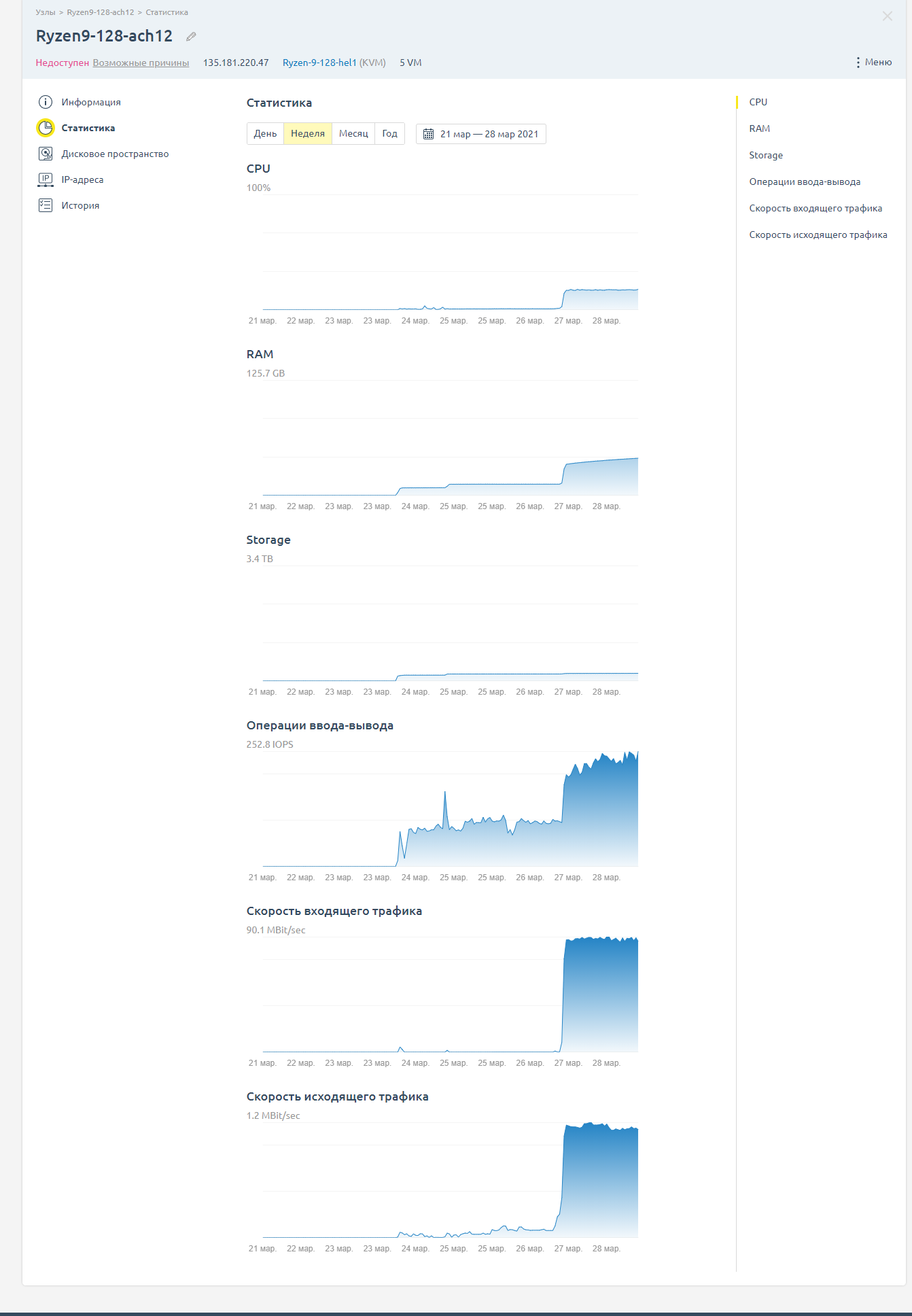

Сервер просто 2 дня работал и сразу начал сбоить

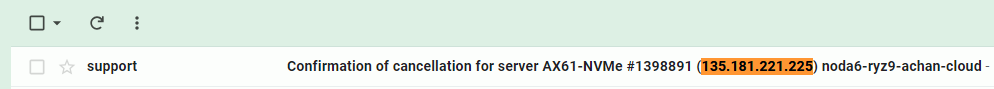

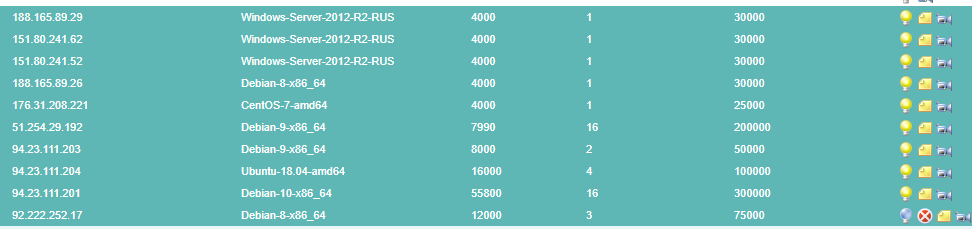

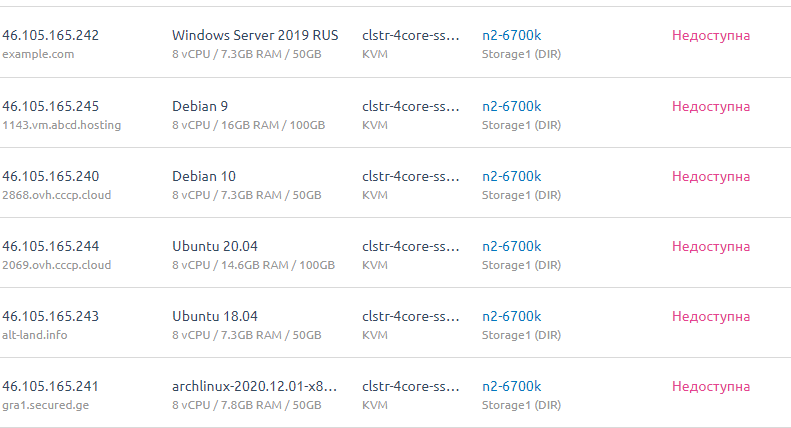

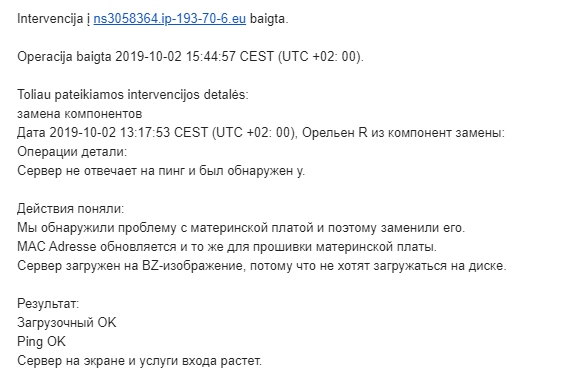

Сделали отказ.

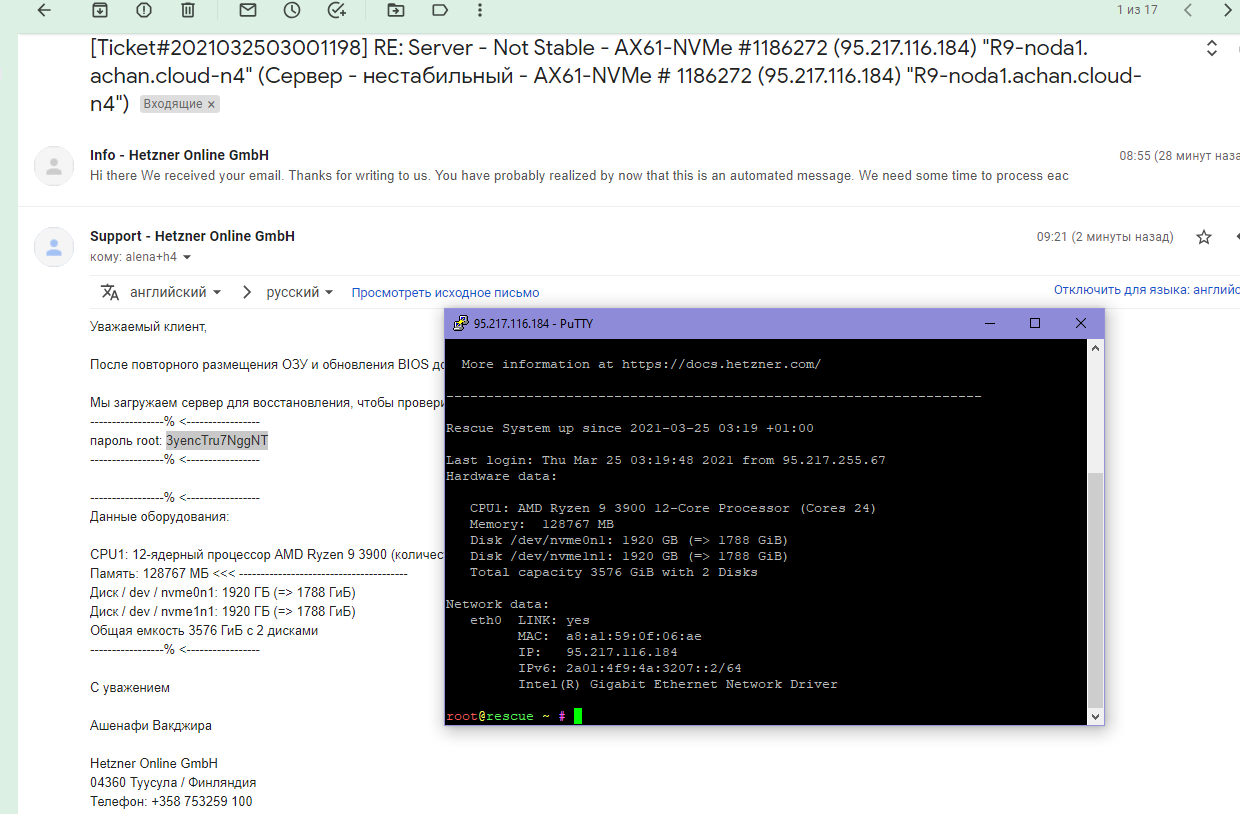

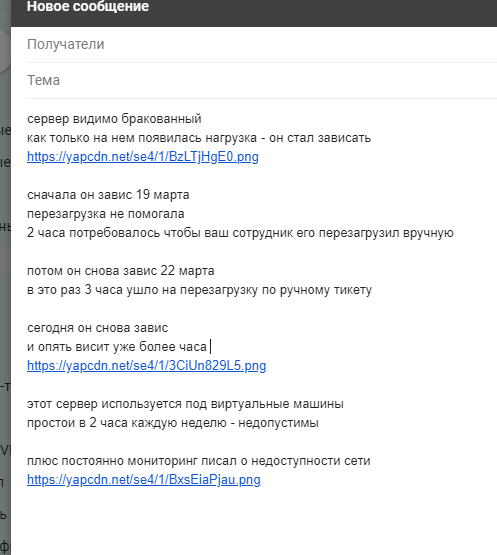

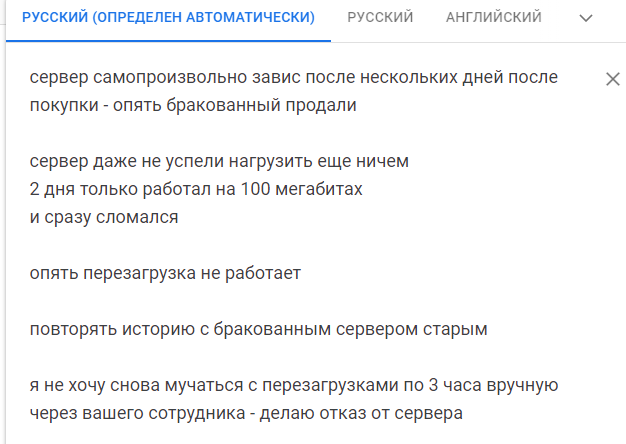

Написали текст

Сервер просто 2 дня работал и сразу начал сбоить

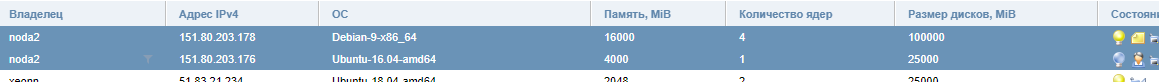

Сделали отказ.

Написали текст