История VM на базе [VMmanager 5 KVM 2017-2020 годы by кошелек alice2k]

Много истории вы уже можете видеть на портале vm.center

vm.center/blog/vmmanager/

vm.center/blog/qa-vmmanager/

Но так же есть серия топиков, честных.

И хочу чтобы они были всем доступны тоже. Поэтому скопирую, чтобы потом не искать. Вряд-ли уже напишу новые топики про VM-5, поэтому одним постом обобщаю опыт для потомков.

Но зато мы неплохо прокачали скидку ISPsystem.

И десятки хостеров были настроены нами :)

Абсолютно бесплатно!

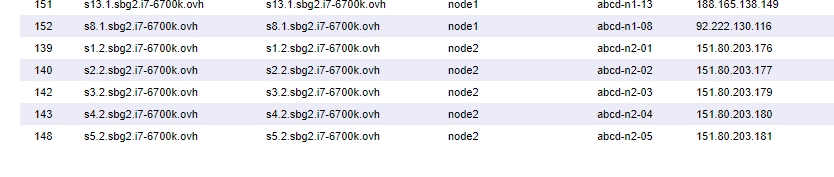

Мы ввели в стандарт подобные «честные доли». И именно после нас все остальные начали делать VM на десктоп процессорах, т.к. мы доказали, что они работают не хуже чем энтерпрайз.

Нашу идею кто только не скопировал.

И даже VMmanager 6 — стала делать панель для модели «на базе аренда дедик ОВХ где сетка на каждом узле своя». То что мы мучались в VM-5 — было решено в VM-6.

Но это уже, совершенно другая история, про которую я напишу еще через пару лет. В историю.

vm.center/blog/vmmanager/

vm.center/blog/qa-vmmanager/

Но так же есть серия топиков, честных.

И хочу чтобы они были всем доступны тоже. Поэтому скопирую, чтобы потом не искать. Вряд-ли уже напишу новые топики про VM-5, поэтому одним постом обобщаю опыт для потомков.

- Как я хотел сделать красиво, но не получилось — октябрь 2020

- Но вот я делал просто от балды, абсолютно убыточные услуги 2016-2019 годы

- Захотелось потратить денег — январь 2020

- Есть ли будущее у VM ? — ноябрь 2019

- Увеличить продажи VM — апрель 2019

- Публичный отчет №2 — март 2019

- Куда развивать виртуальные услуги? № 3 — январь 2019

- Куда развивать виртуальные услуги? № 2 — сент 2018

- Куда развивать виртуальные услуги ? — май 2018

- Небольшой отчет о виртуальном — март 2018

- В НГ писался отчет (в низу вывод о VPS за 2017, статья 2016 оказалась правдой)

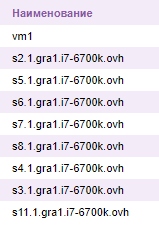

- VDS — list.skladchik.ovh — август 2017

- Решил создать свои ТРЕШ вдс-ки — май 2017

- Свободные доли VMmanager — май 2017

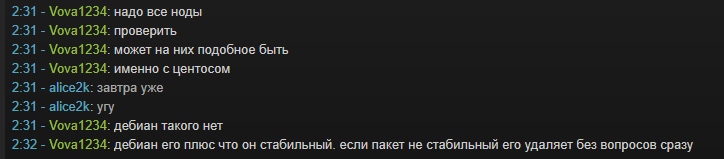

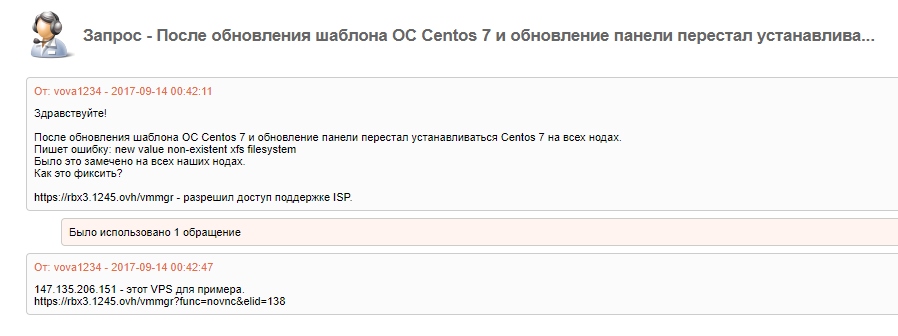

- Vmmnager — вчера убили весь день — июнь 2017

- Как услуги деграданты убивают людей — январь 2017

Но зато мы неплохо прокачали скидку ISPsystem.

И десятки хостеров были настроены нами :)

Абсолютно бесплатно!

Мы ввели в стандарт подобные «честные доли». И именно после нас все остальные начали делать VM на десктоп процессорах, т.к. мы доказали, что они работают не хуже чем энтерпрайз.

Нашу идею кто только не скопировал.

И даже VMmanager 6 — стала делать панель для модели «на базе аренда дедик ОВХ где сетка на каждом узле своя». То что мы мучались в VM-5 — было решено в VM-6.

Но это уже, совершенно другая история, про которую я напишу еще через пару лет. В историю.