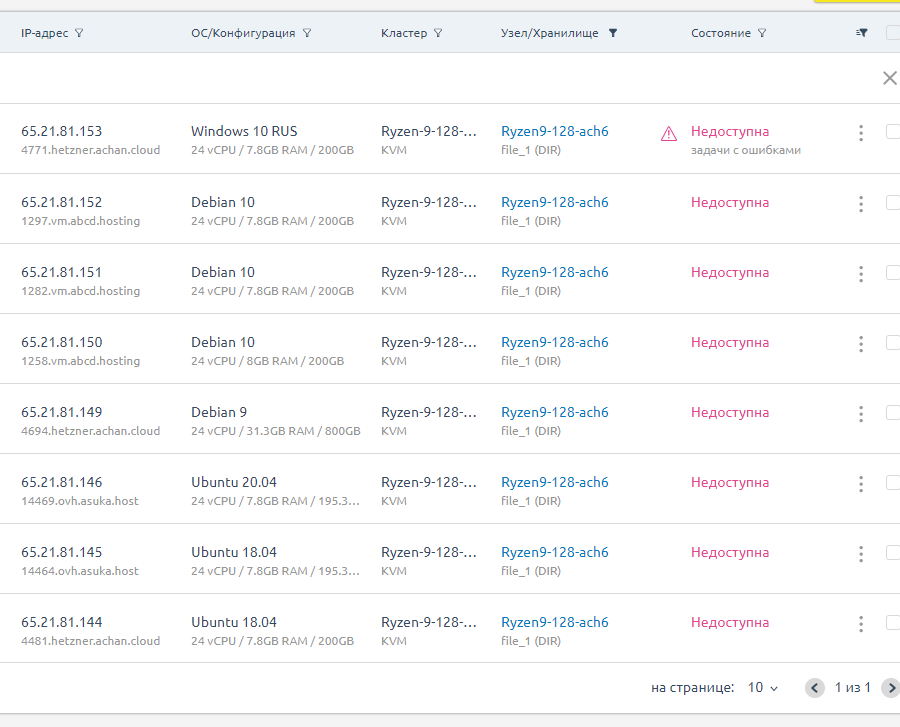

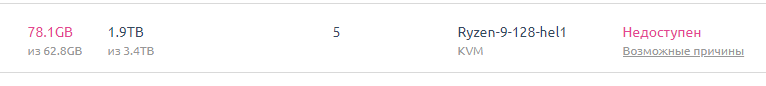

Ryzen 9 - самая первая нода новинка 2020 года которая

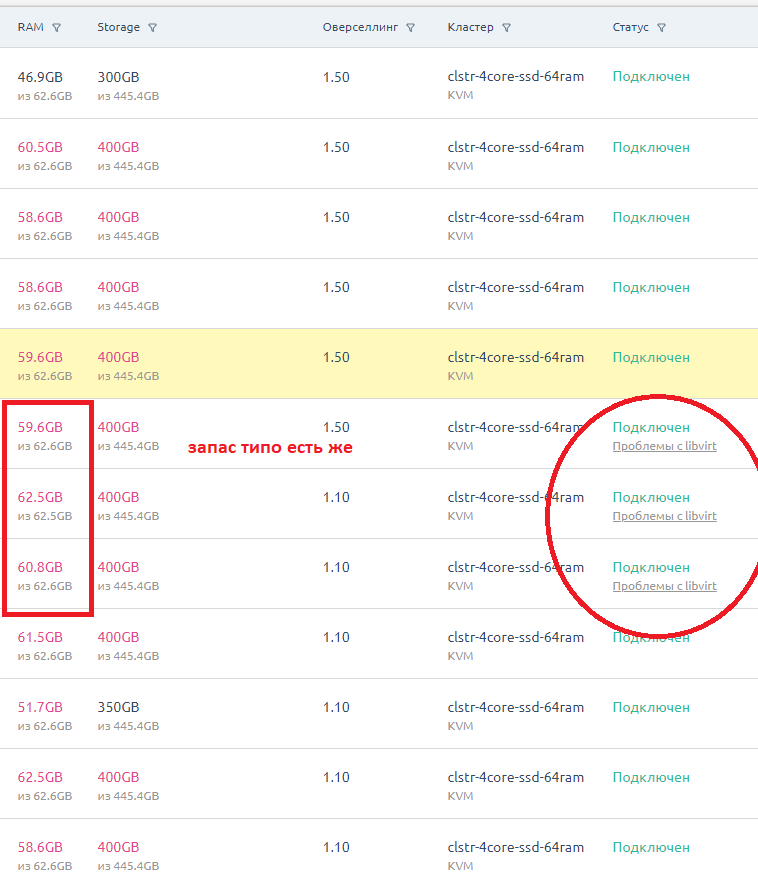

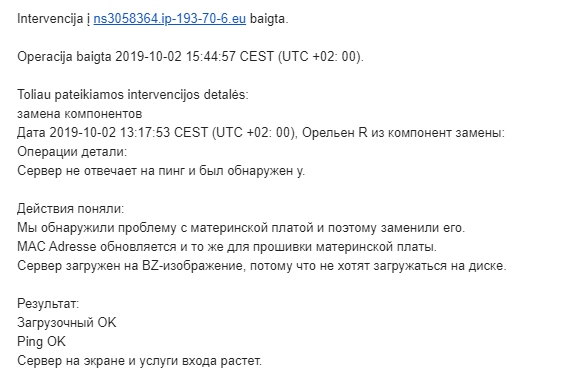

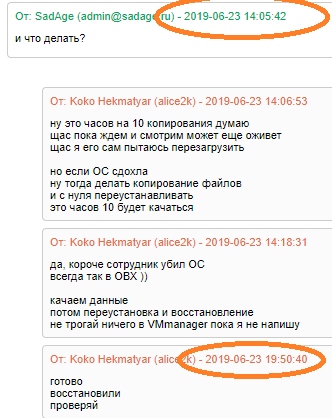

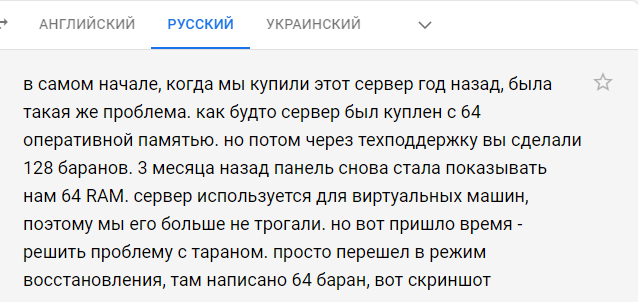

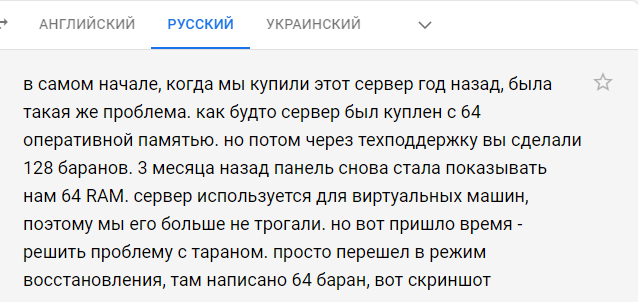

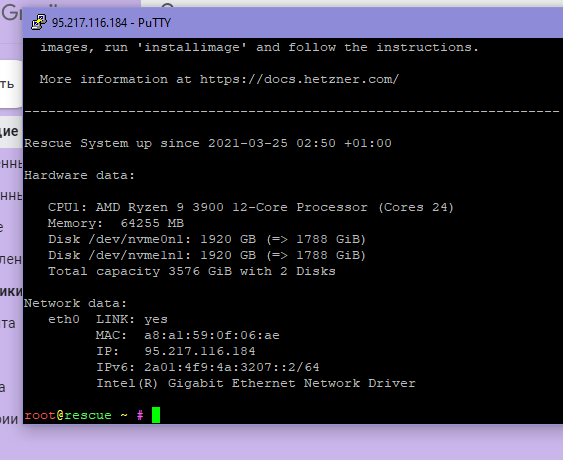

Короче как только мы ее купили. Нам продали 64 озу вместо 128 озу.

В 2020 году еще мы переписывались с ДЦ и они там потом починили.

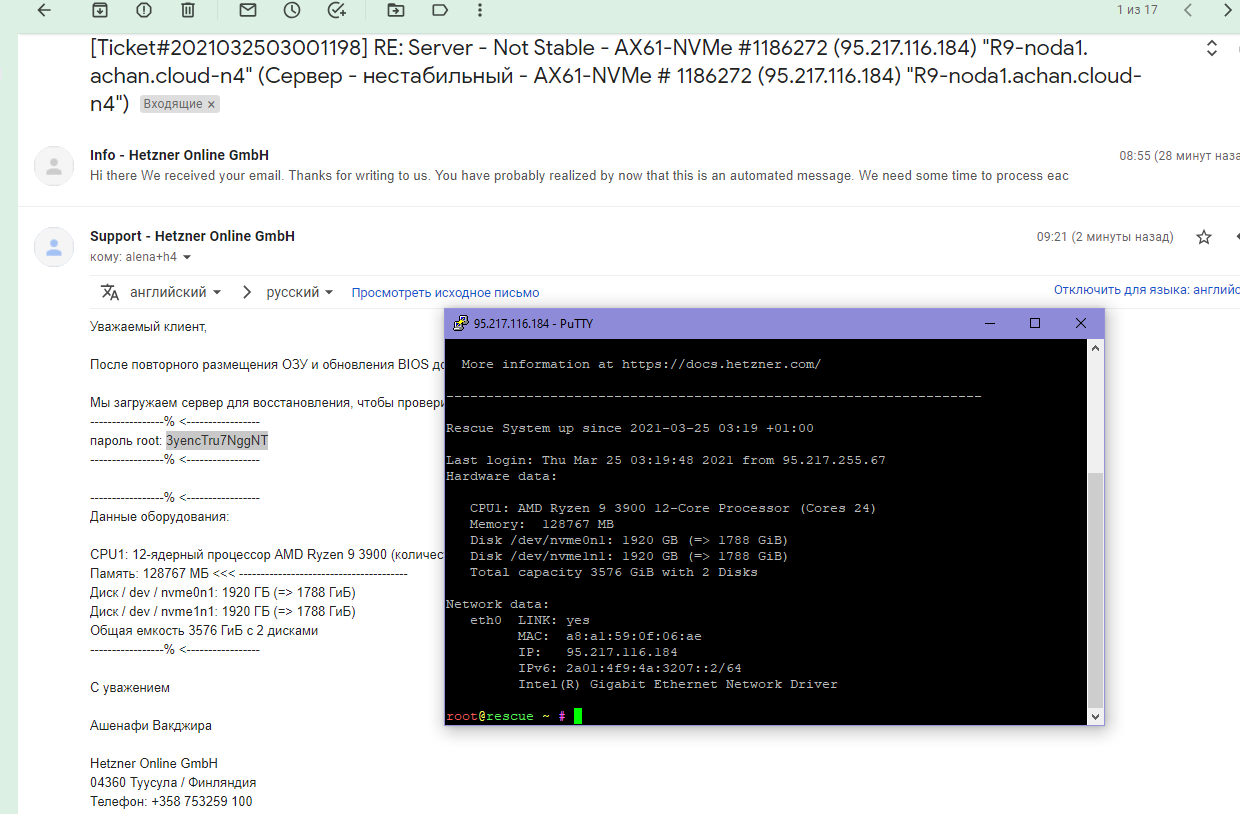

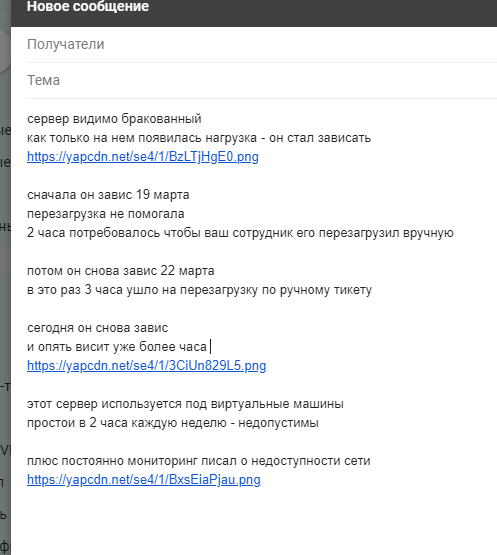

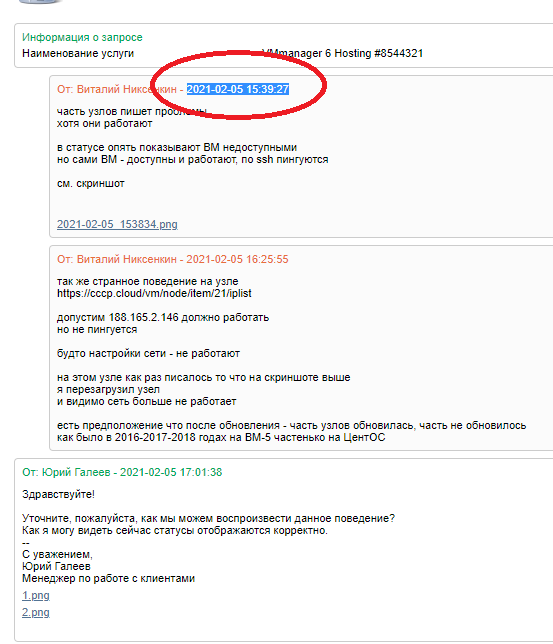

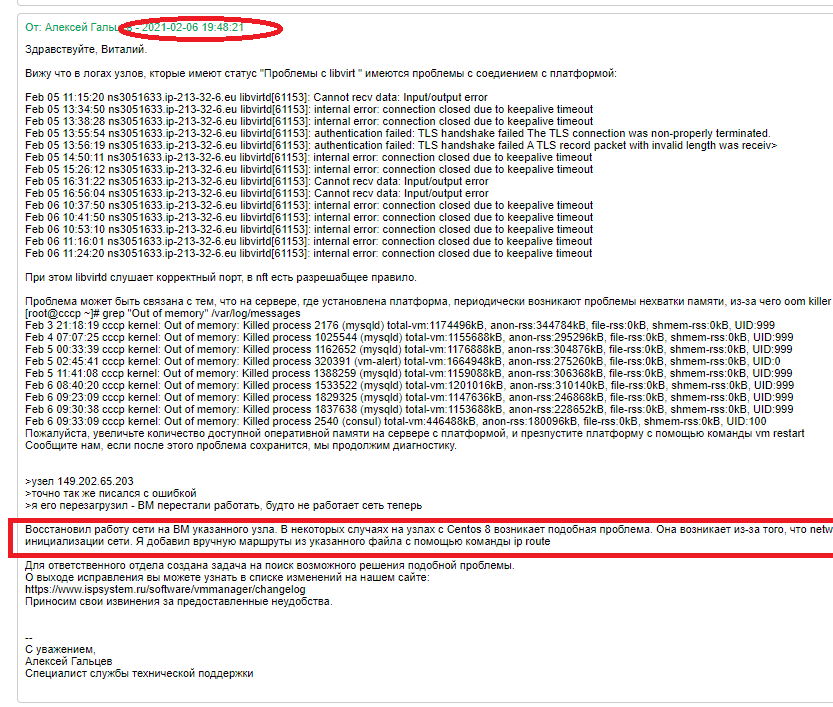

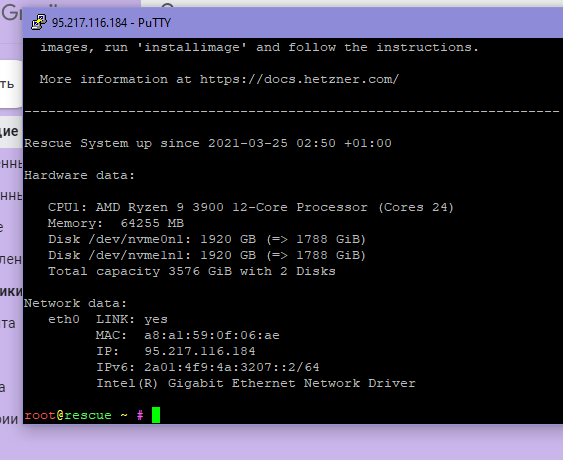

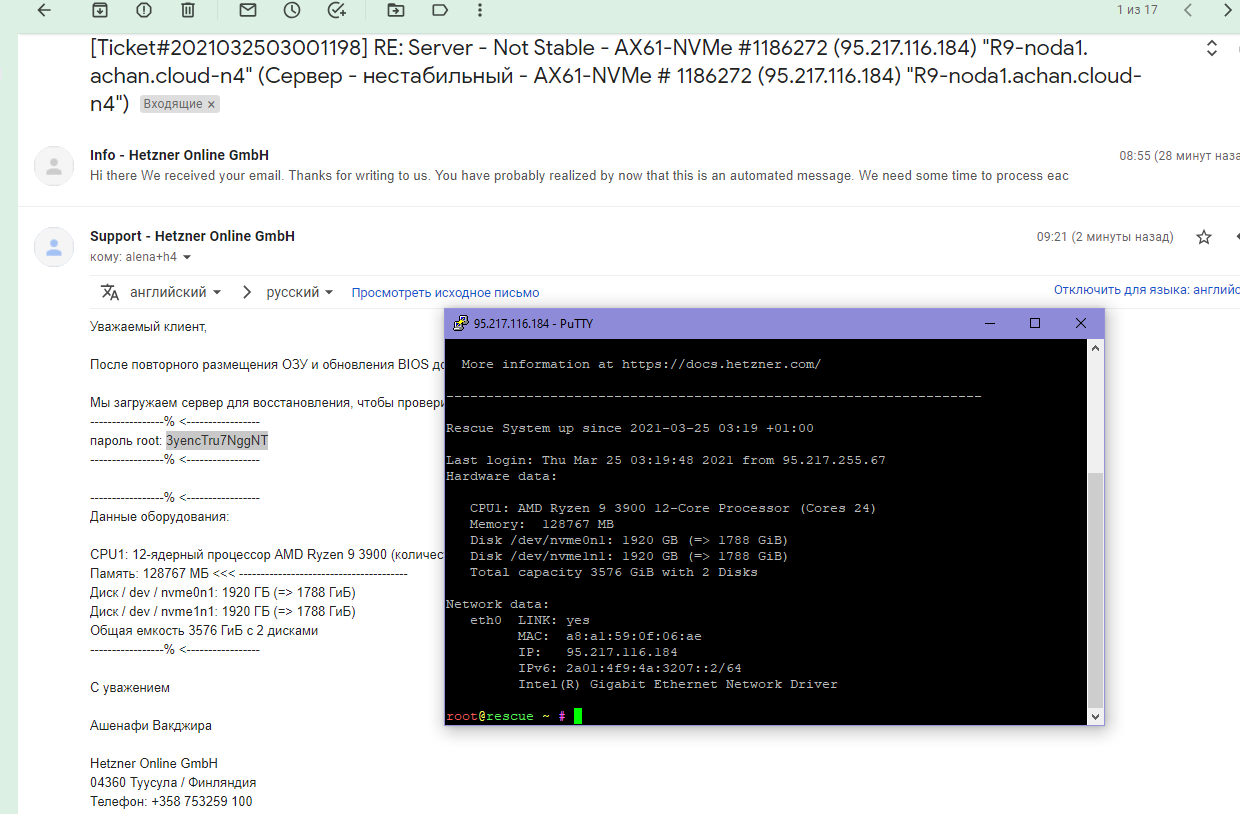

Но в 2021 снова произошло это дело.

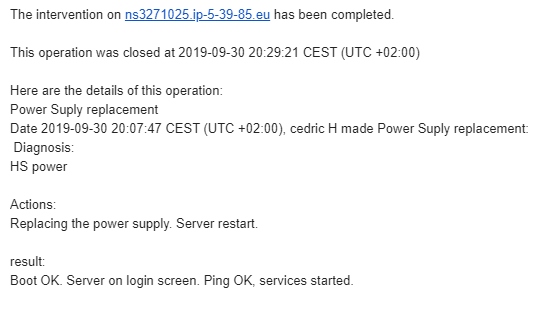

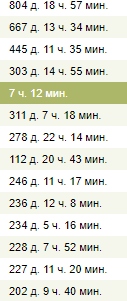

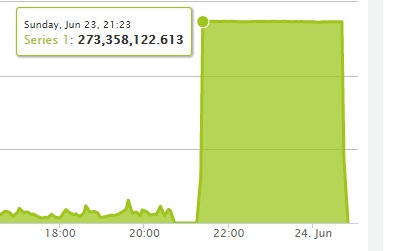

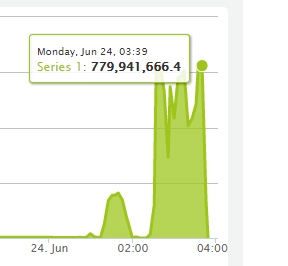

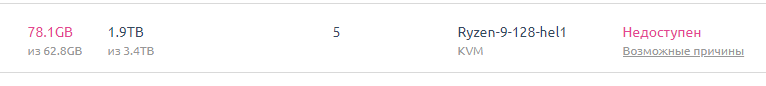

Поэтому простой ноды — вот публичный отчет. Около часа валялась.

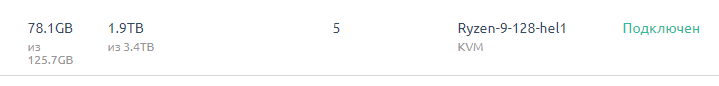

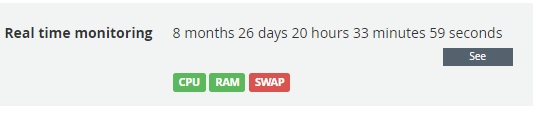

После починки

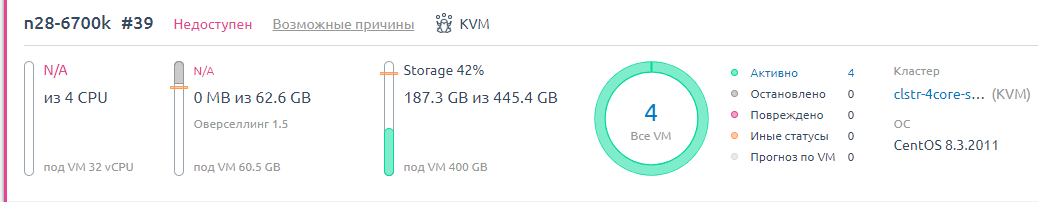

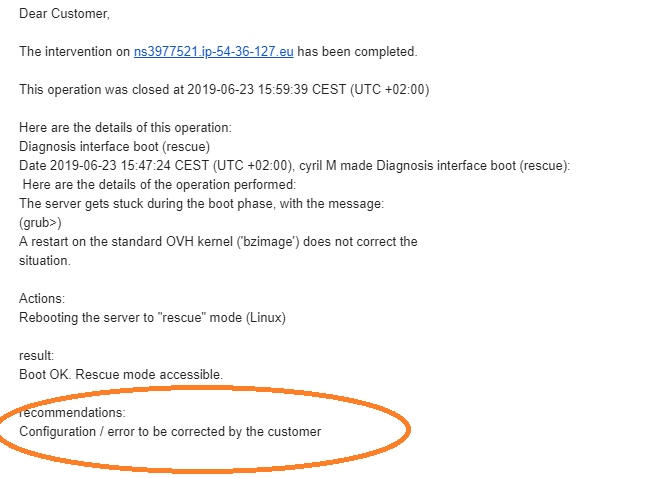

В 2020 году еще мы переписывались с ДЦ и они там потом починили.

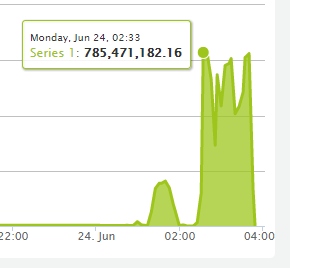

Но в 2021 снова произошло это дело.

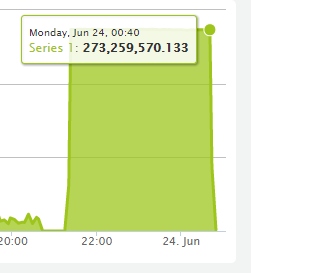

Поэтому простой ноды — вот публичный отчет. Около часа валялась.

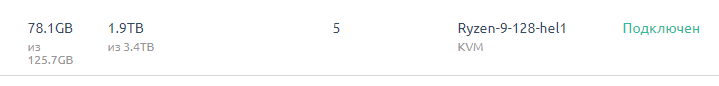

После починки