Как мы настраиваем ноды

Просто как роботы. Когда-то я даже 1000 серверов как робот целые сутки сидел и обрабатывал. С апреля по ноябрь шла выдача в ДЦ. Постоянно каждый день складировал по таблицам по 10-15-20 серверов. (были заметки раз, два)

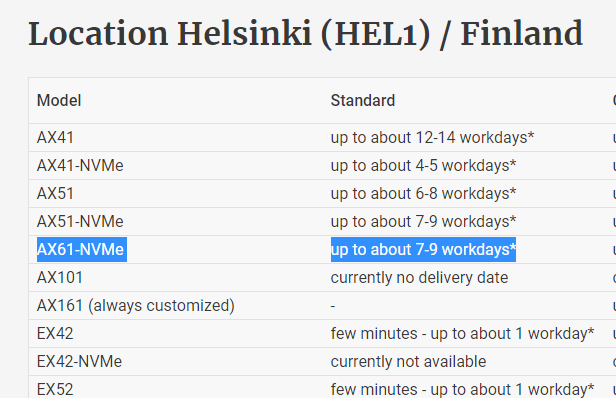

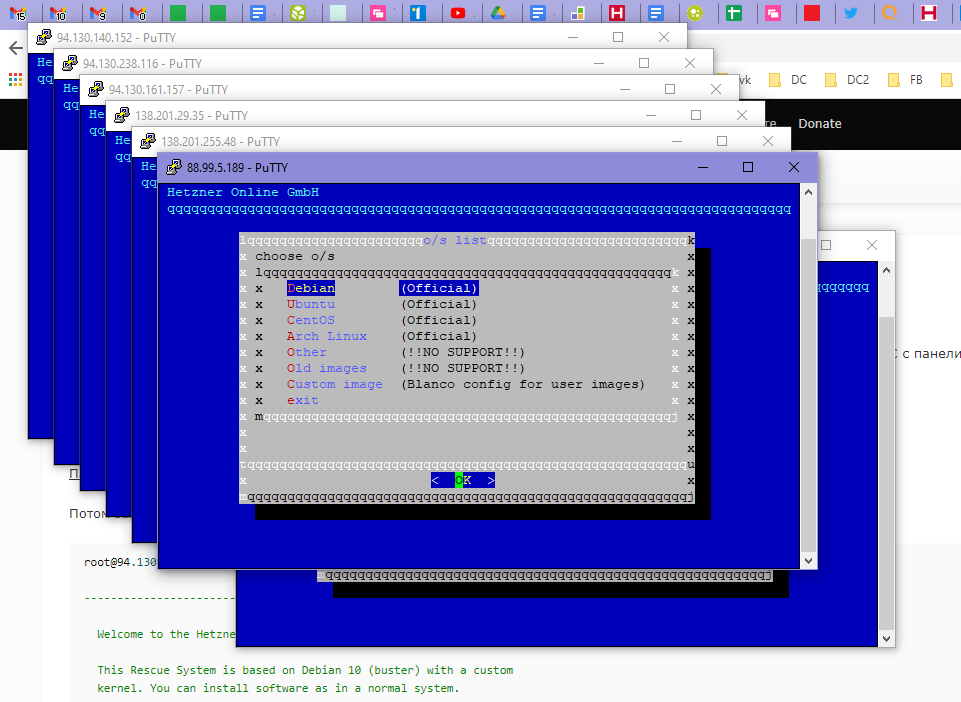

Итак, делаем заказ на новые серверы.

Их потом выдают пачкой. Через 10 минут.

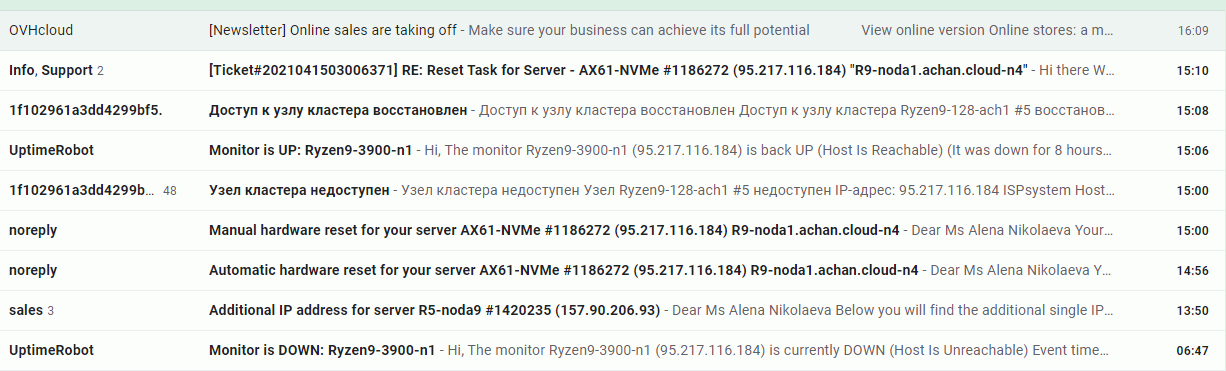

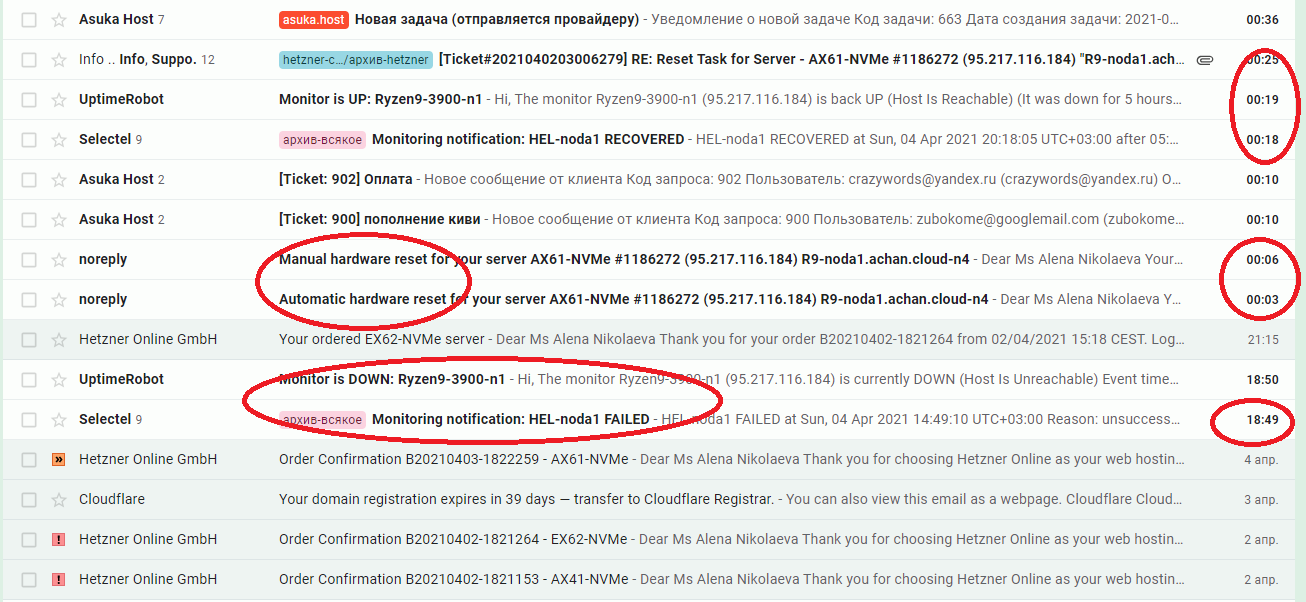

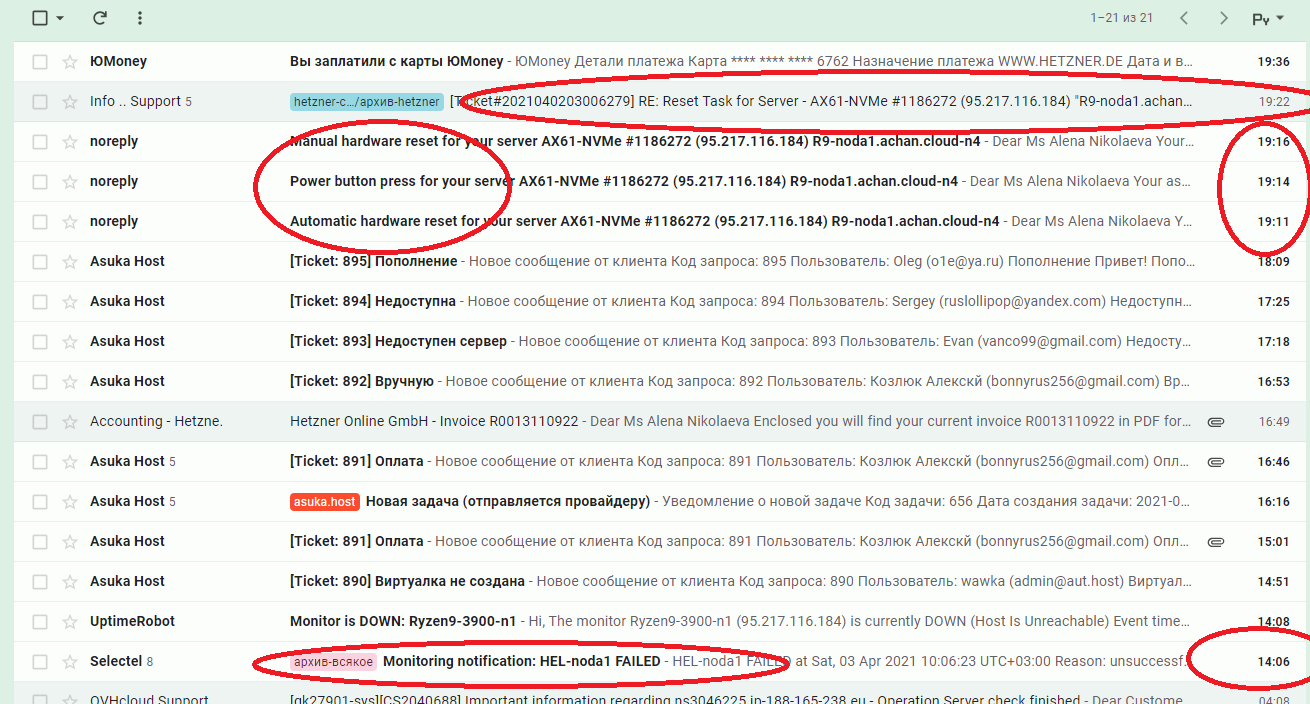

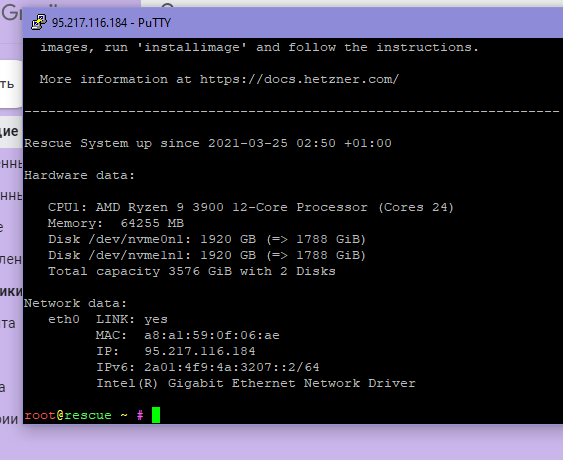

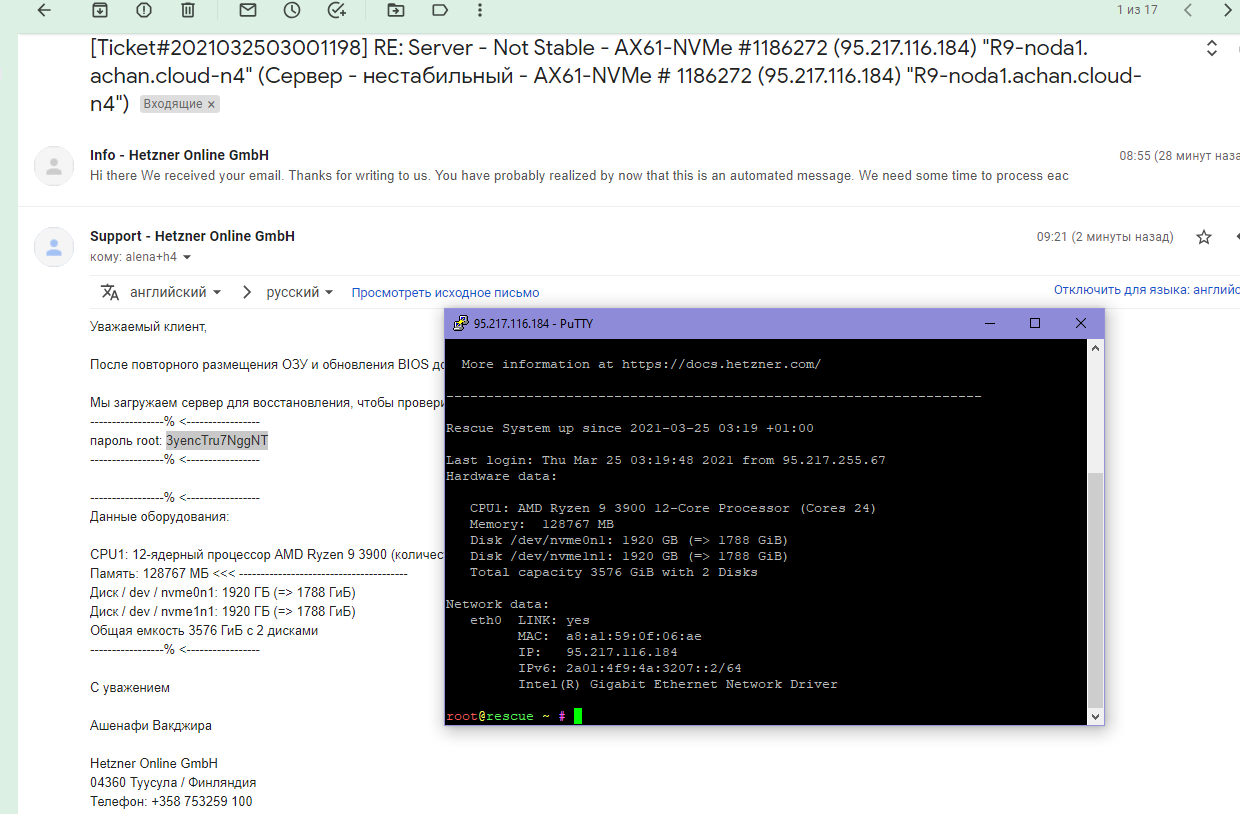

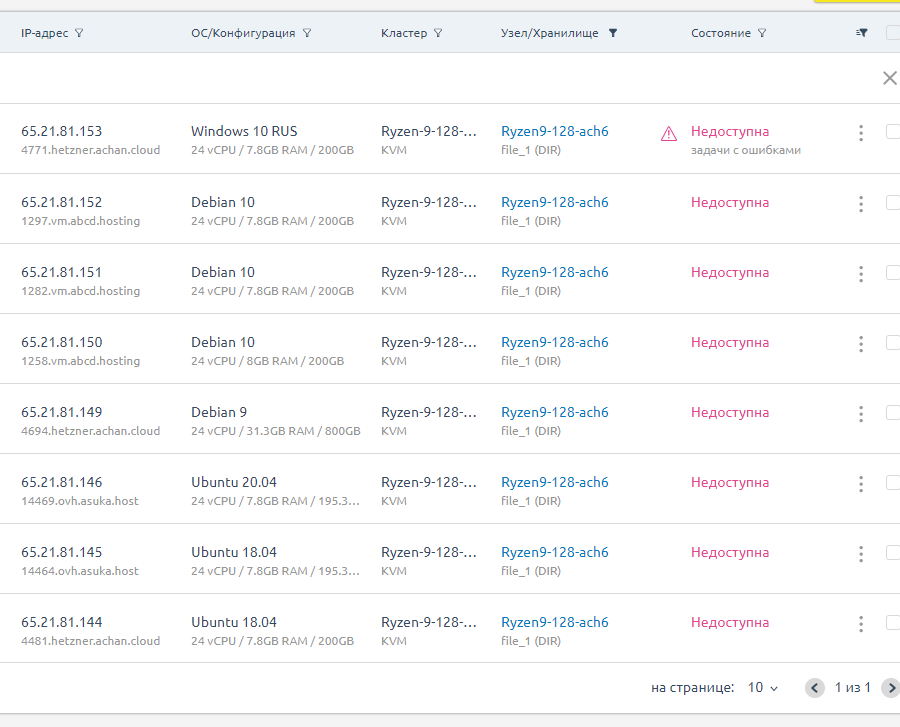

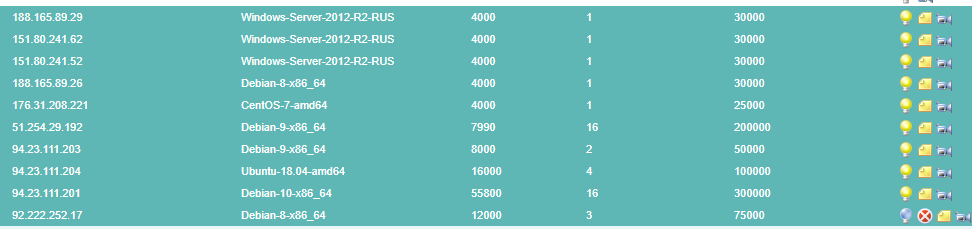

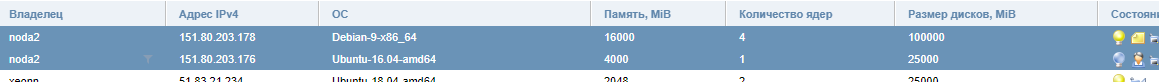

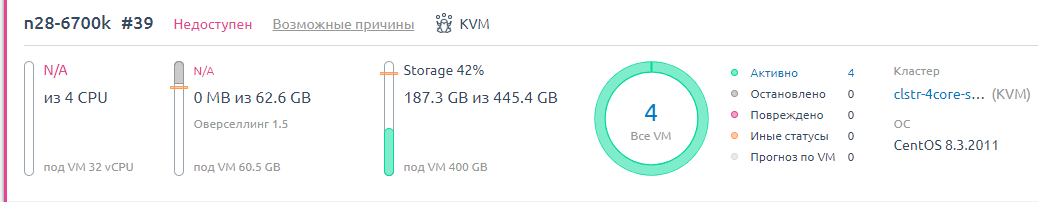

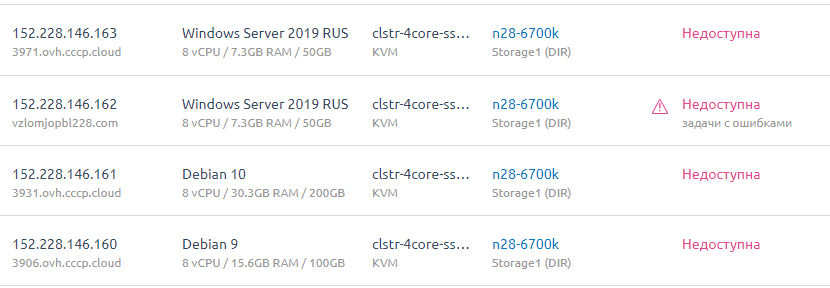

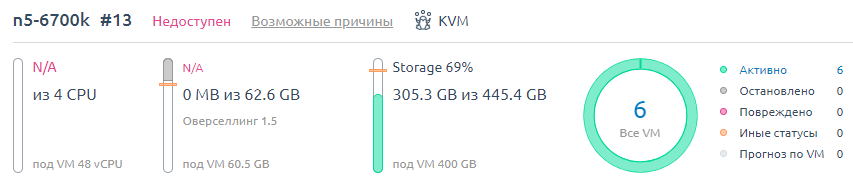

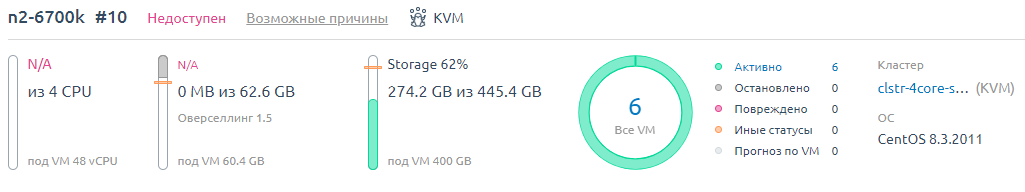

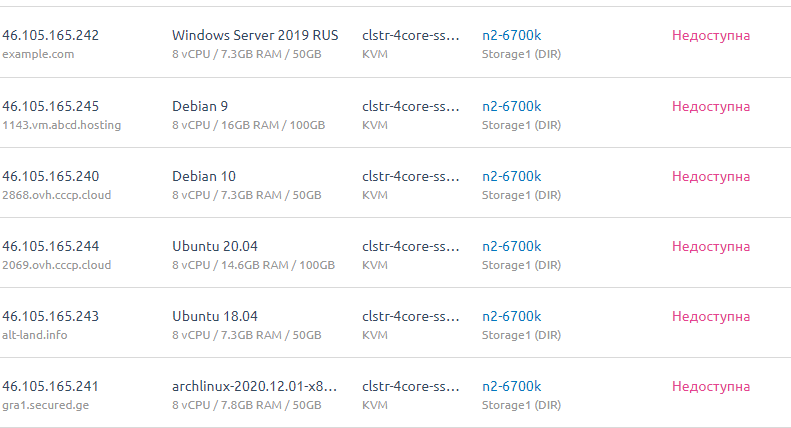

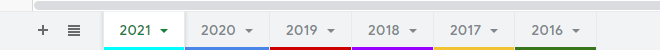

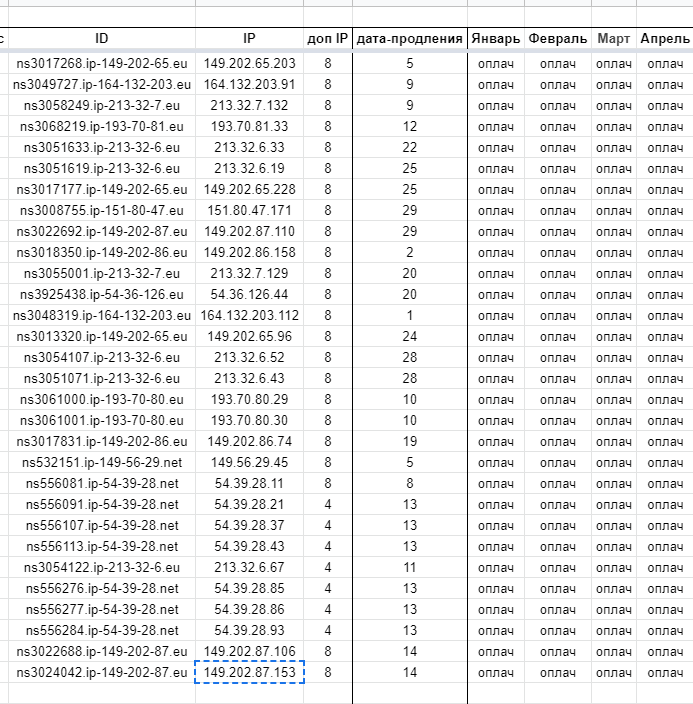

Каждый запускаем и записываем пароли и IP и характеристики в таблицы.

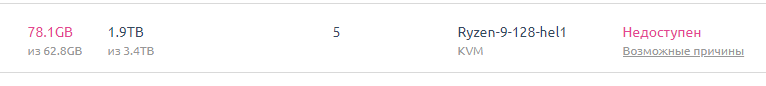

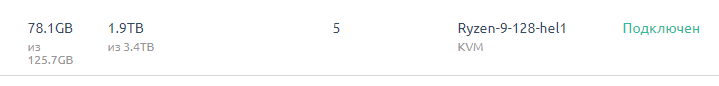

Например ОВХ красиво смотрится, у хетзнера таблицы попроще.

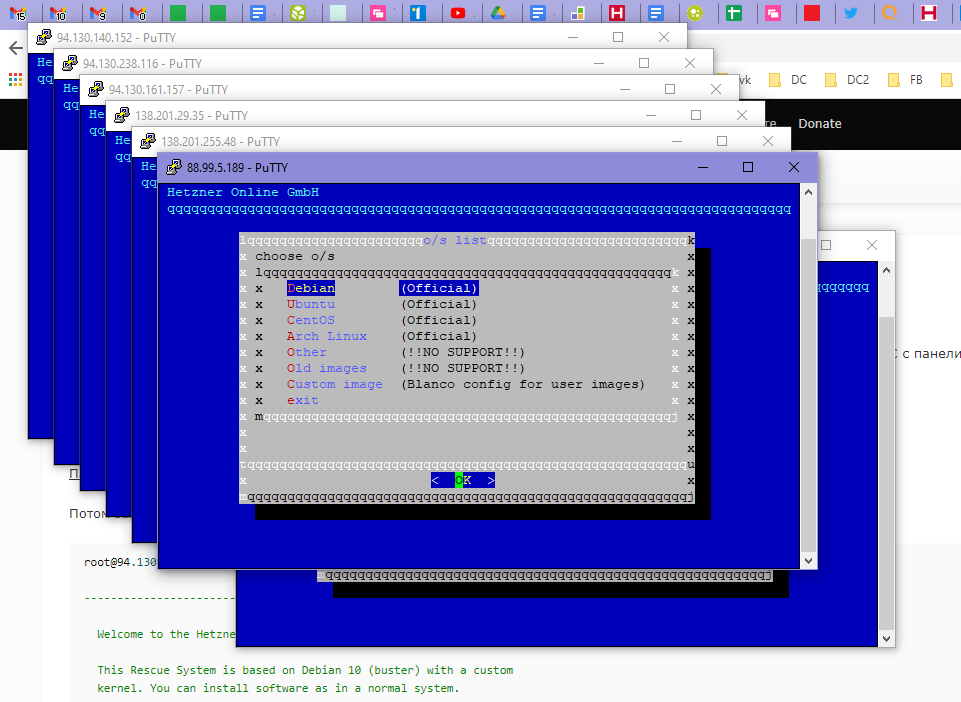

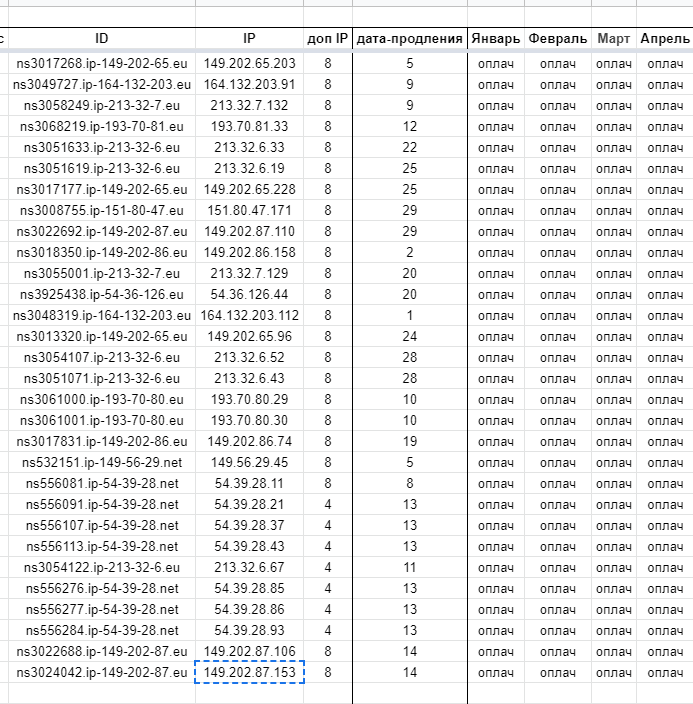

И накатываем ОС сразу разом на все.

Читать дальше

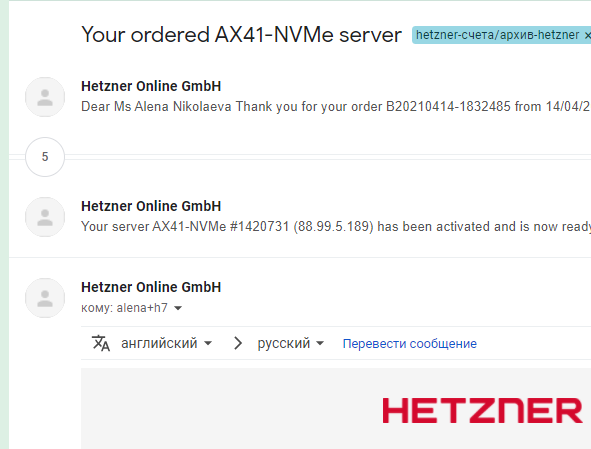

Итак, делаем заказ на новые серверы.

Их потом выдают пачкой. Через 10 минут.

Каждый запускаем и записываем пароли и IP и характеристики в таблицы.

Например ОВХ красиво смотрится, у хетзнера таблицы попроще.

И накатываем ОС сразу разом на все.