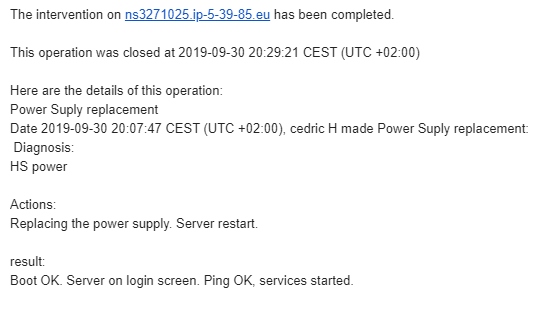

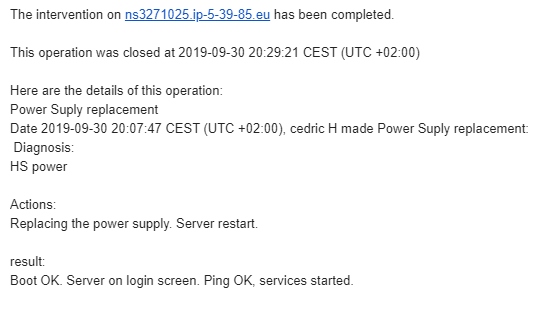

noda5.1245 Power Suply replacement

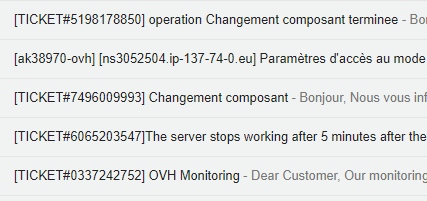

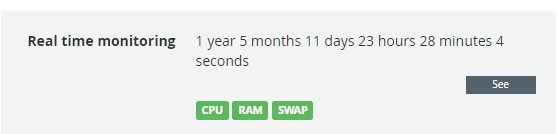

[TICKET#8046222242] Operation Power Suply replacement finished

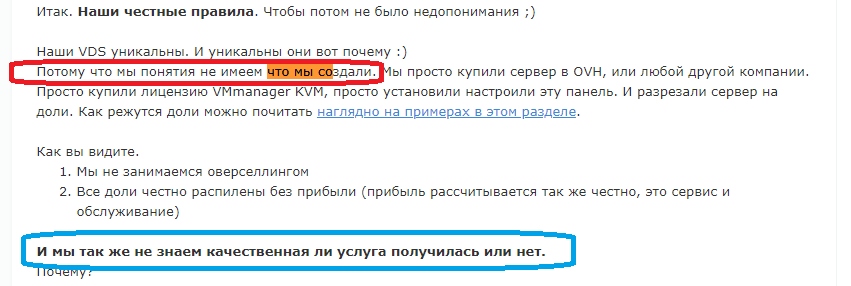

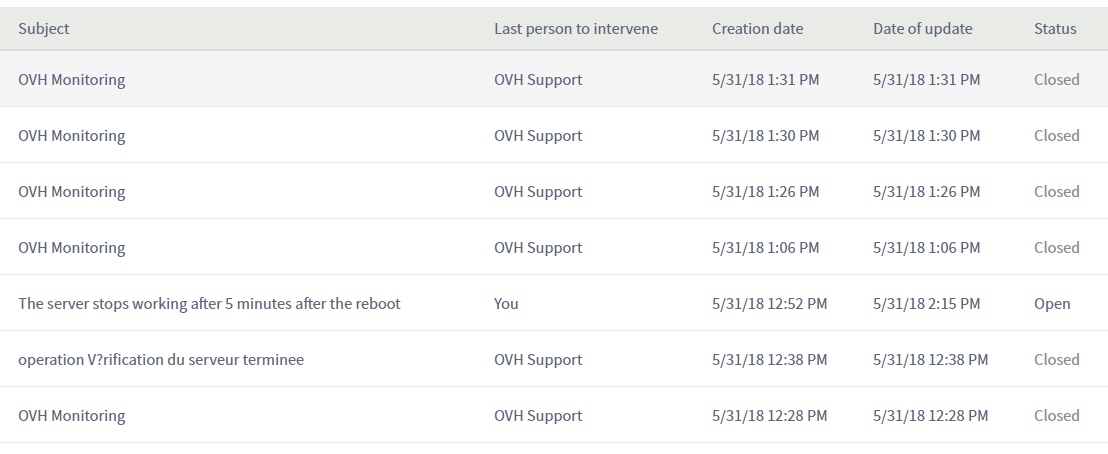

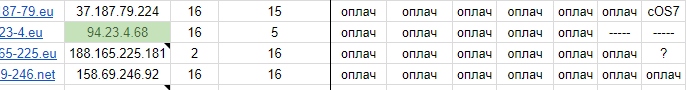

Похоже никто не заметил даже, тикетов создано не было.

Но для истории топик. Все по честному.

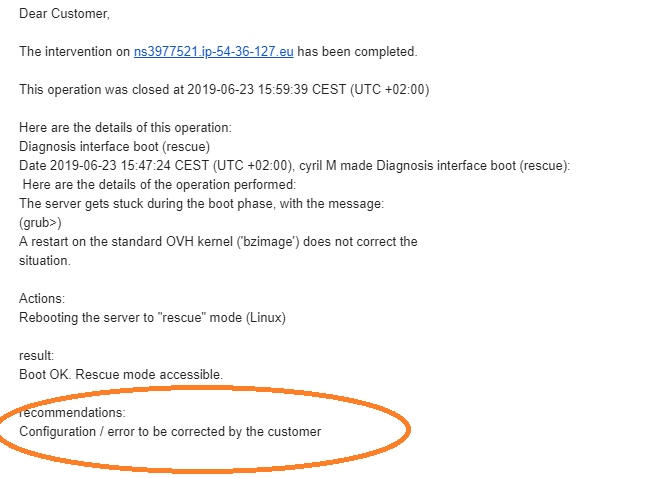

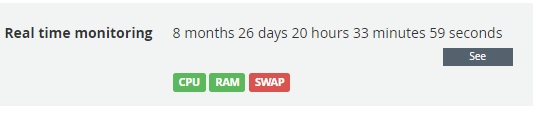

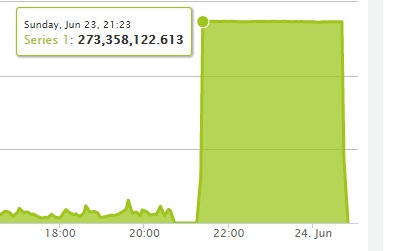

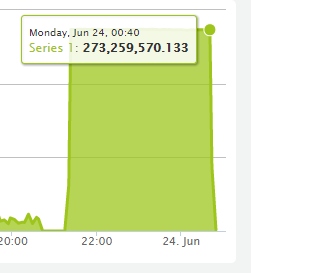

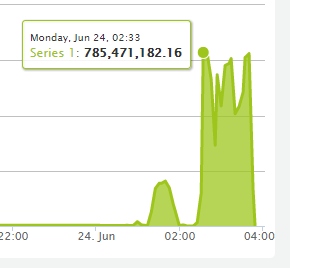

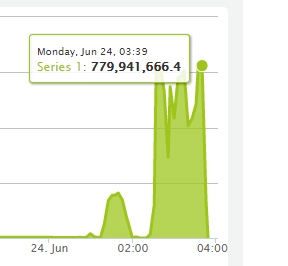

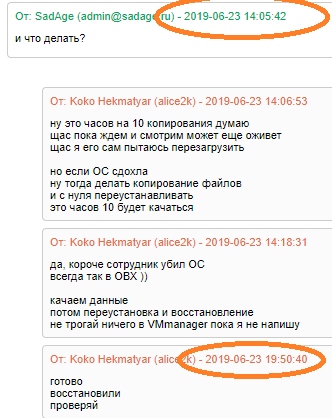

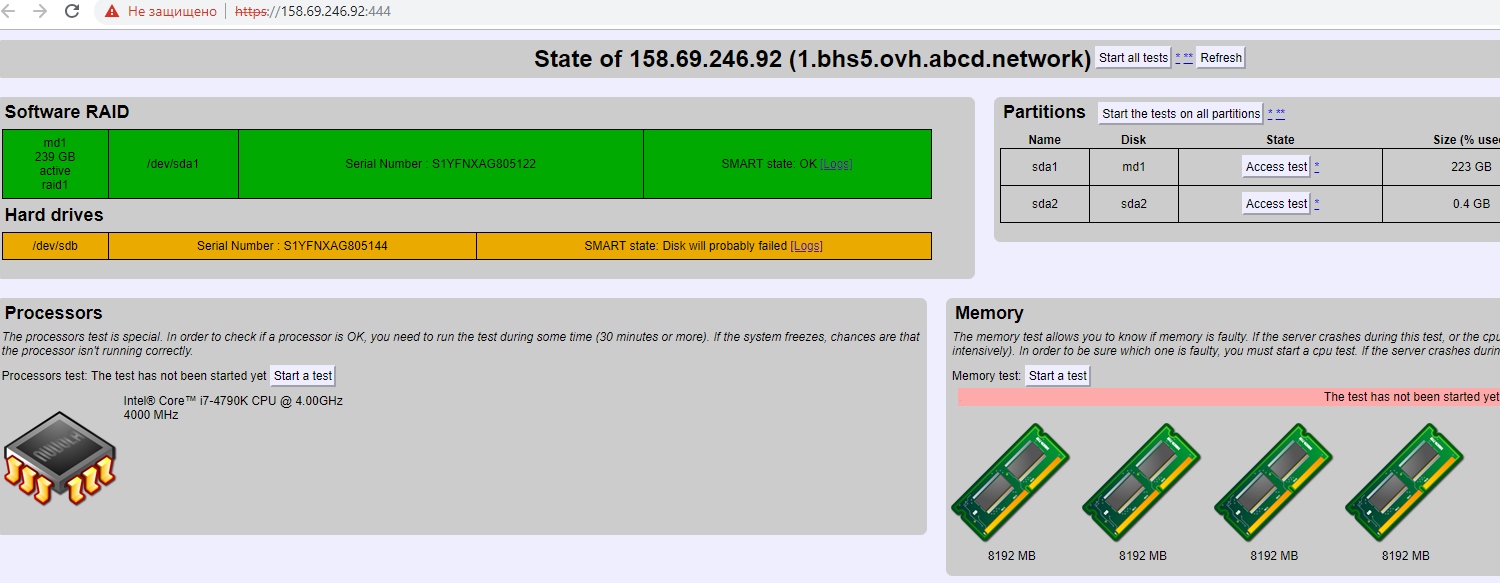

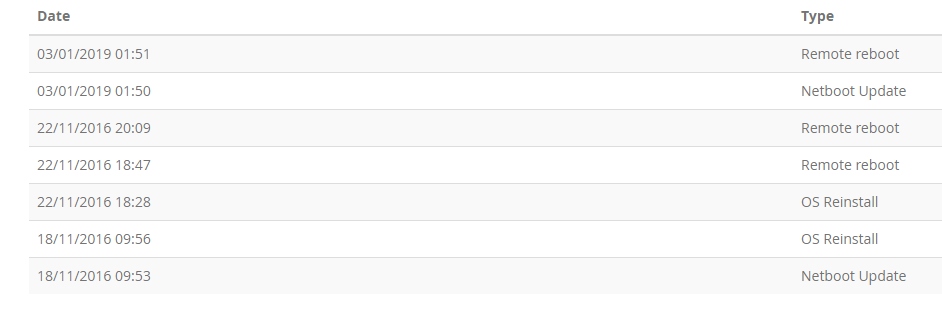

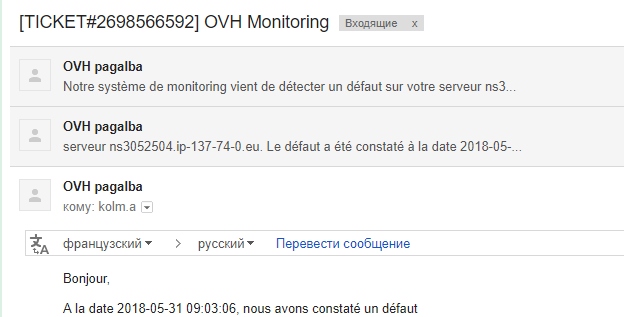

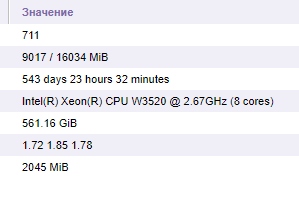

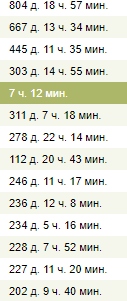

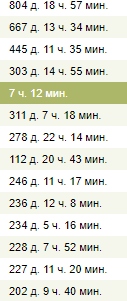

- Проснулся я значит с утра. Вижу там БП сгорел и его поменяли, автоматически сами в ОВХ.

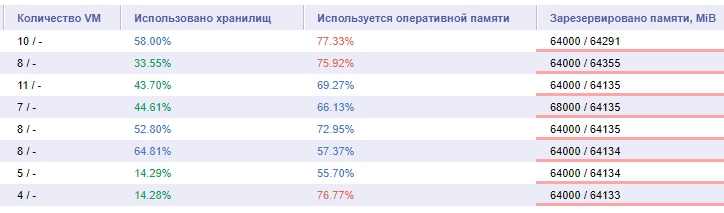

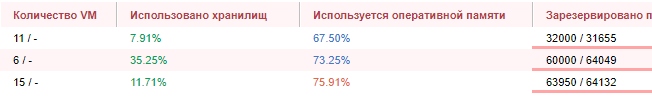

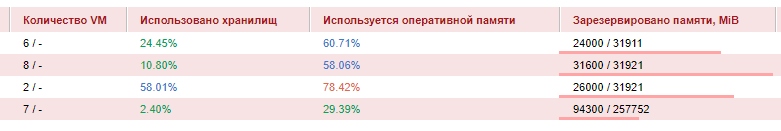

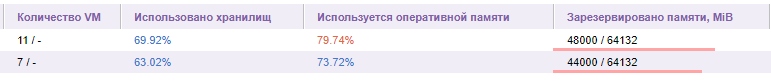

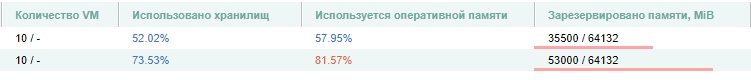

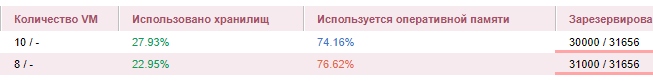

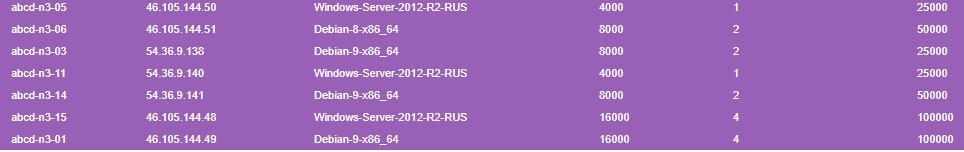

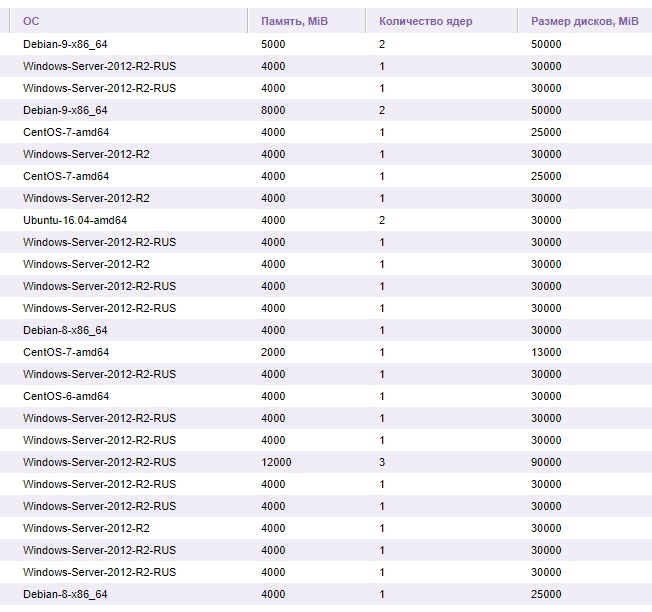

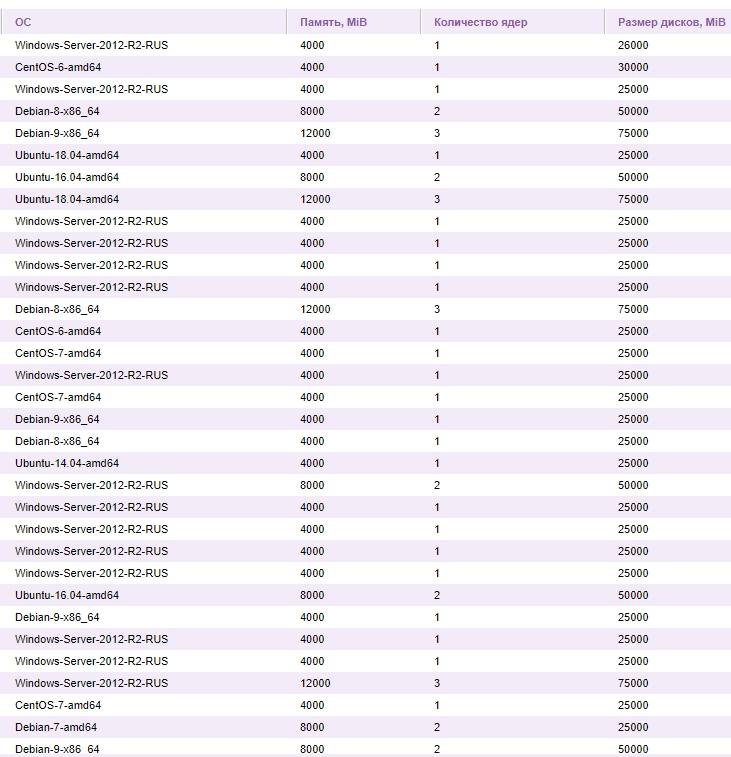

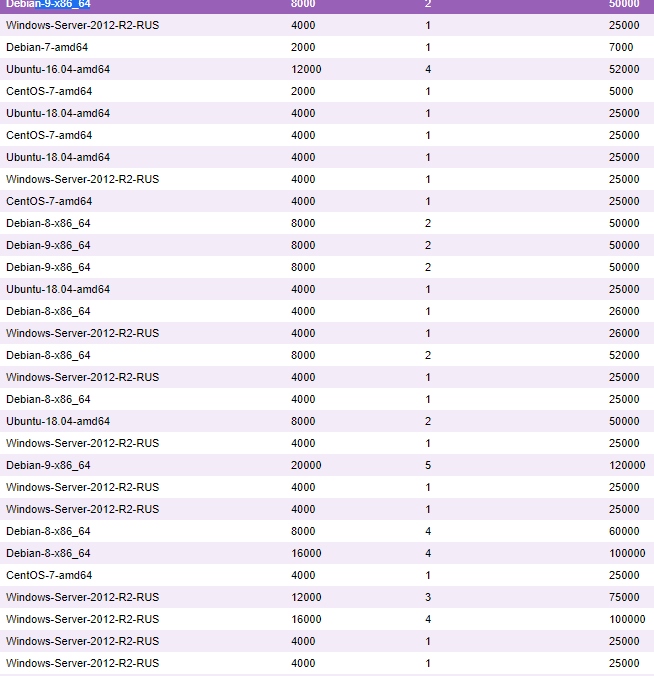

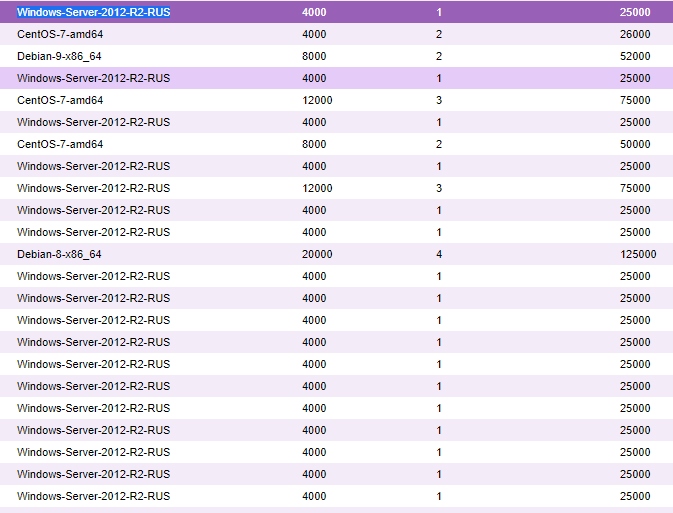

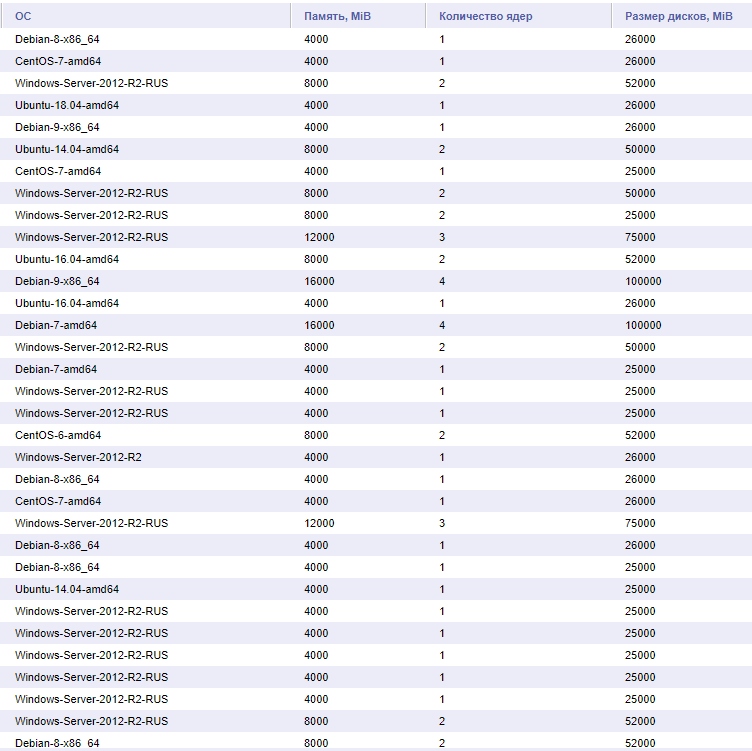

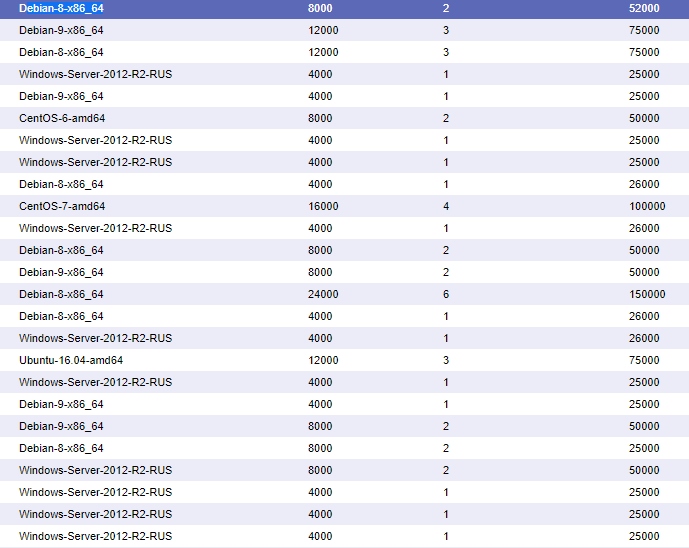

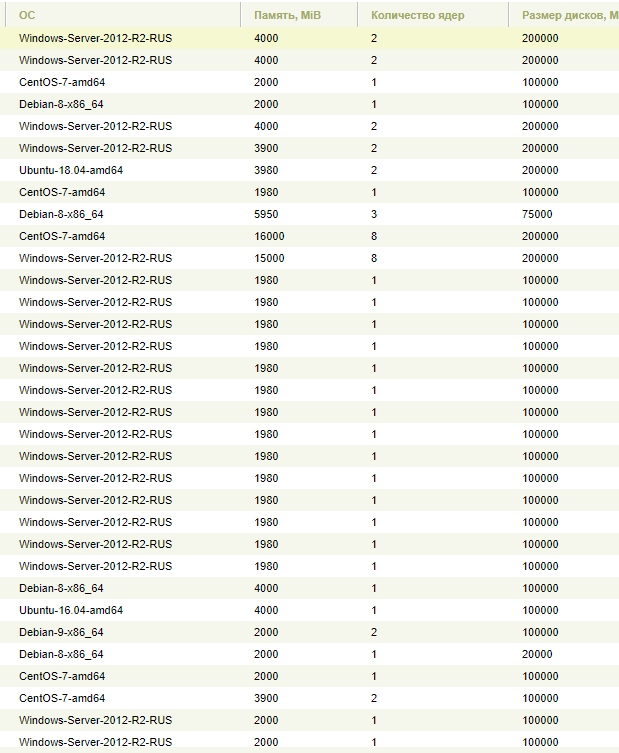

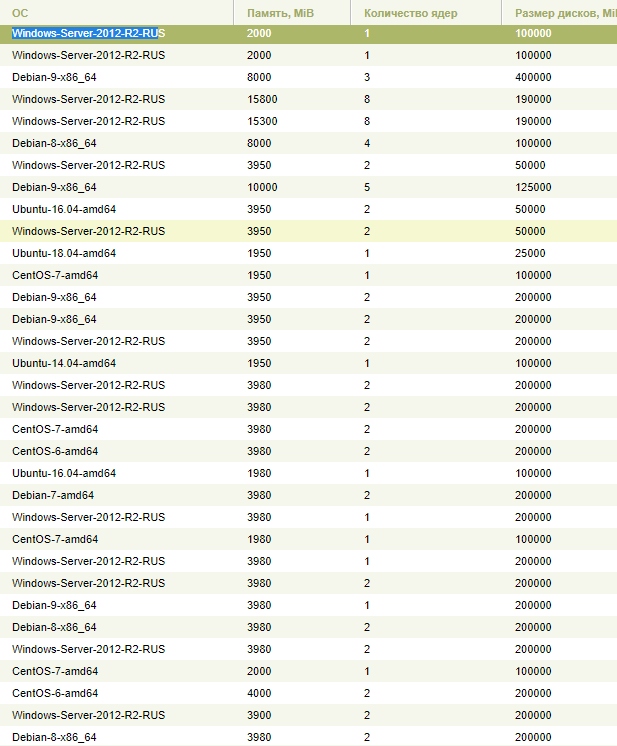

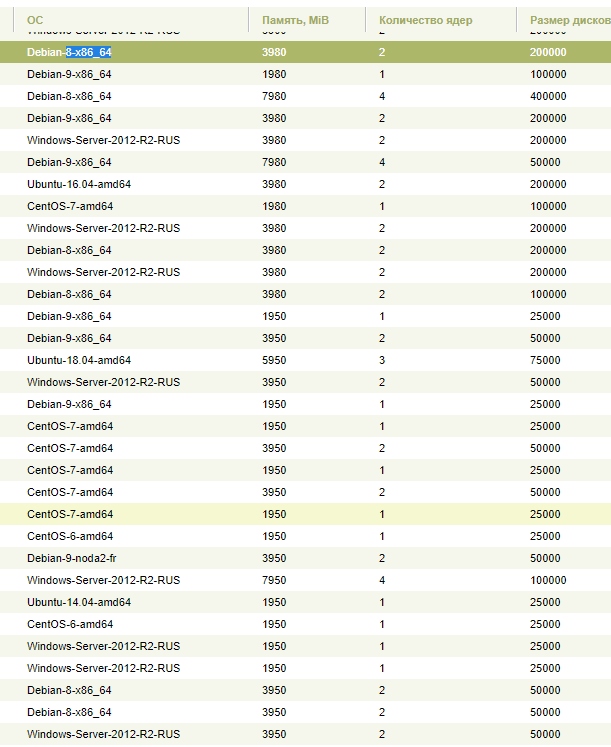

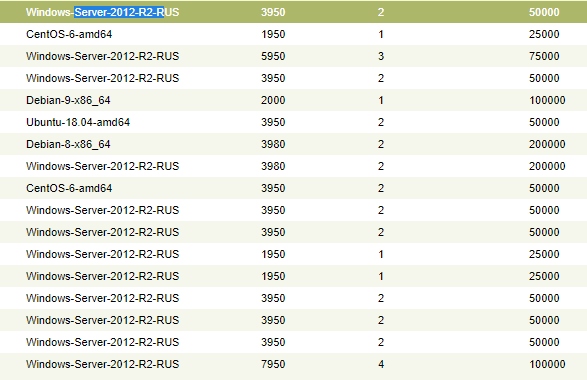

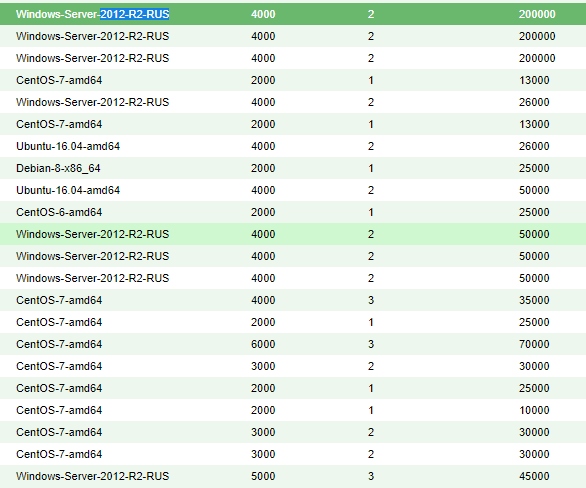

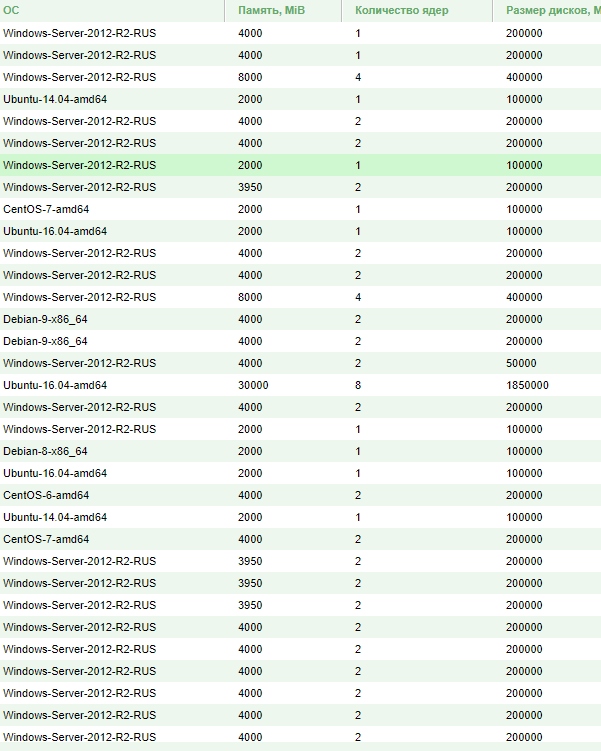

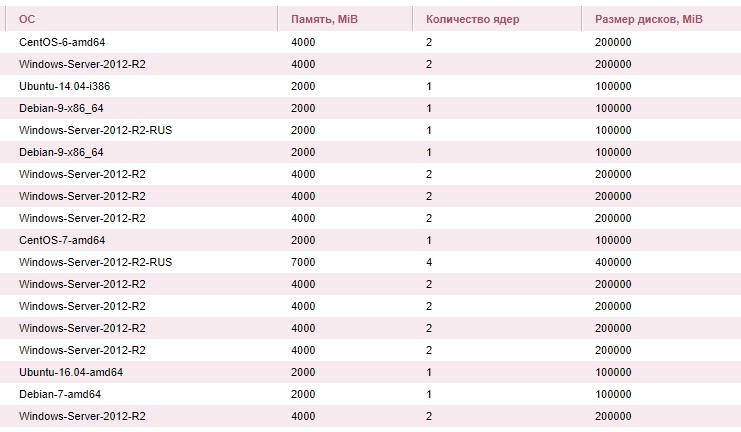

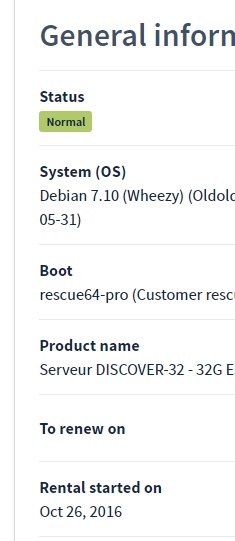

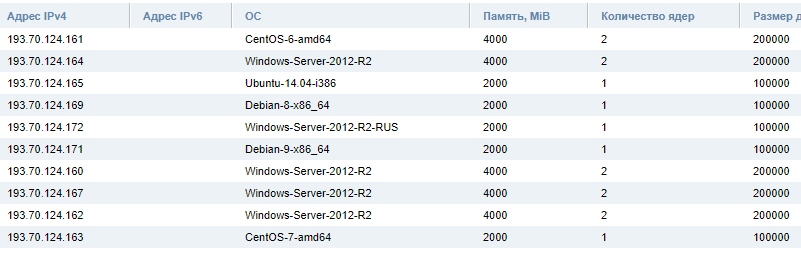

- Как видно в узлах E3-1245v2

Похоже никто не заметил даже, тикетов создано не было.

Но для истории топик. Все по честному.