vm.spacecore.pro [noda6]

Представляем вашему вниманию нашу новую ноду [NODA6] в одном из лучших дата центров в Германии с AntiDDos защитой и каналом в 1 GBit/s. Нужно больше скорости? Новые NVME диски в 3 раза быстрее даже самых высокоскоростных SSD и все это по самой низкой цене на рынке!

Конфигурация:

Intel i7-6700 4c/8t 4.2GHz

64GB DDR4

2x520GB NVME SSD

1 GBit/s

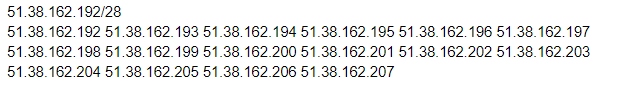

Локация: Германия

Тариф на 1 долю

(можно добавлять)

1 vCore i7-6700

4 GB DDR4-памяти

50 GB NMVe SSD

1 GBit/s

Standard-AntiDDos

Старт 11-2019 год — цена 350р

Контакты для связи:

Email: support@spacecore.pro

Telegram: @spacecore_pro

VK: https://vk.com/spacecore_pro