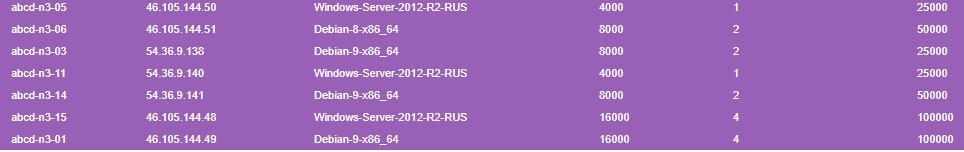

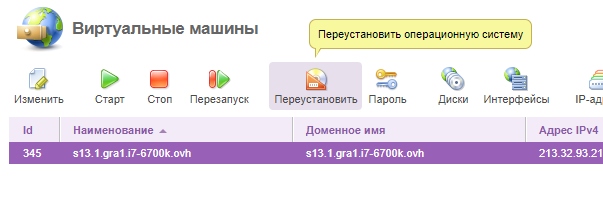

node1.vm.host-host.ru

Конфигурация:

- Intel Xeon E3-1245v2 4c/8t 3.4GHz

- 32GB DDR3 1333 MHz

- SoftRAID 2x480GB SSD

- 250 Mbps

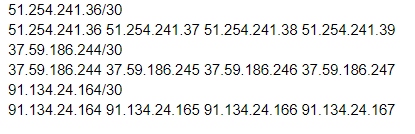

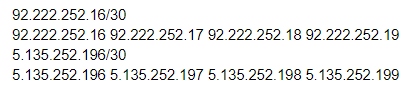

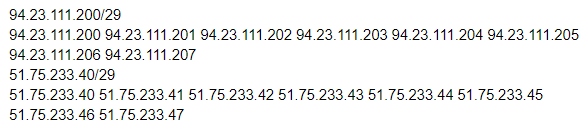

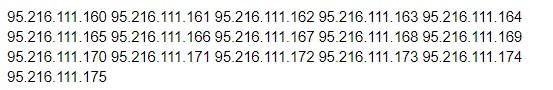

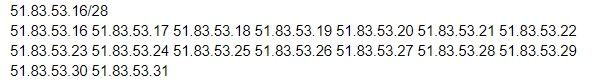

- Подсеть: 51.91.204.96/28

- Локация: Франция

Стоимость первого месяца:

- E3-SSD-1-32 — 30 евро

- Установочная плата — 20 евро

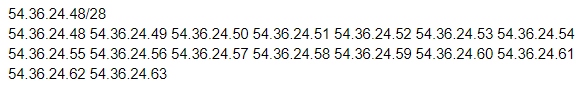

- 16 IP-адресов — 16 евро

- Панель VMmanager KVM — 5 евро

По курсу 73 рубля = 1 евро, получаем 71 * 73 ~ 5200 рублей.

Стоимость последующих месяцев:

- E3-SSD-1-32 — 30 евро

- Панель VMmanager KVM — 5 евро

По курсу 73 рубля = 1 евро, получаем 35 * 73 ~ 2560 рублей.

Доля:

- 1 ядро Intel Xeon E3-1245v2

- 2ГБ RAM

- 25 SSD

- IPV4-адрес из подсети

Дополнения:

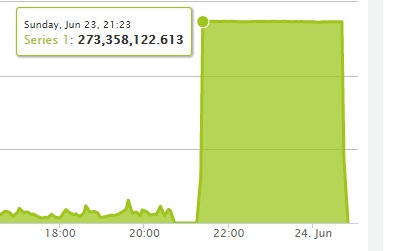

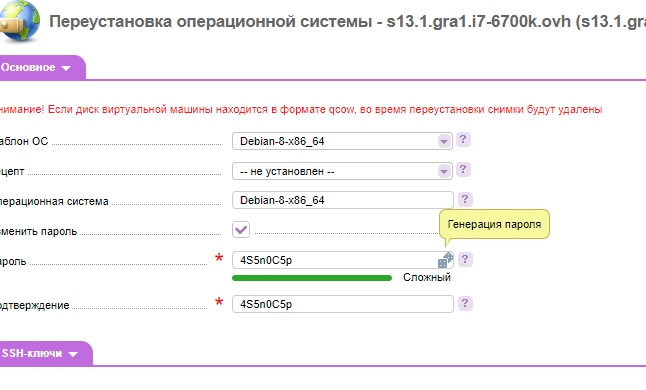

- Сервер уже настроен и готов выдавать доли уже сейчас

- Нода подключена к биллингу, за который платить не надо

- Если сильной загруженности не будет, можно каждому по 2 ядра дать

- Можно организовать хранилище резервных копий VDS с FTP для каждого, никаких панелей там не будет, чистый ProFTPD, ценник от 0.75р/ГБ до 1р/ГБ

- Можно организовать еще 2 ноды до 1 августа

Итоговая стоимость:

Первый месяц: 400 рублей.

Со 2 месяца: 300 рублей.

Контакты для связи:

Контакт на всех ресурсах ABCD: StreserМыло: streser@abcdteam.eu